IDS120 - Étude de la proposition de règlement européen pour l'Intelligence Artificielle dans le secteur de la Santé

Les projets ou stages publiés auxquels vous accédez sont des rapports d'étudiants et doivent être pris comme tels. Il peuvent donc comporter des imperfections ou des imprécisions que tout lecteur doit admettre et donc supporter. Il ont été réalisés pendant les périodes de formation et constituent avant-tout des travaux de compilation bibliographique, d'initiation et d'analyse sur des thématiques associées aux concepts, méthodes, outils et expériences sur les démarches qualité dans les organisations ou sur les technologies en santé.

Si, malgré nos précautions, vous avez des raisons de contester ce droit de diffusion libre, merci de nous en faire part (master@utc.fr), nous nous efforcerons d'y apporter une réponse rapide. L'objectif de la présentation des travaux sur le web est de permettre l'accès à l'information et d'augmenter ainsi la qualité des échanges professionnels.

Nous ne faisons aucun usage commercial des travaux de projet ou de stage publiés, par conséquent les citations des informations et l'emploi des outils mis à disposition sont totalement libres. Dans ce cas, nous vous demandons de respecter les règles d'éthique en citant explicitement et complètement vos sources bibliographiques.

Bonne lecture...

Auteurs

Mariana ALVAREZ

Pricilla FUTU VIMPI NAZOMBO

Kévin GOUFFAUD

Yousra BOUTAROUAIT

Yamina RIDA

Contacts

- Mariana Teresa ALVAREZ GUTIERREZ : mariana.mtag@gmail.com

- Yousra BOUTAROUAIT : yousra.b.21@hotmail.fr

- Kévin GOUFFAUD : kevin.gouffaud@gmail.com

- Yamina RIDA : mina.rida54@gmail.com

- Pricilla FUTU VIMPI NAZOMBO pricillavimpi@hotmail.fr

Citation

A rappeler pour tout usage : Mariana Teresa ALVAREZ GUTIERREZ, Yousra BOUTAROUAIT, Kévin GOUFFAUD, Yamina RIDA, Pricilla FUTU VIMPI NAZOMBO, « Étude de la proposition de règlement européen pour l'Intelligence Artificielle dans le secteur de la Santé », Université de Technologie de Compiègne (France), Master Ingénierie de la Santé, Mémoire de Projet, https://travaux.master.utc.fr/, réf n° IDS120, janvier 2022, https://travaux.master.utc.fr/formations-master/ingenierie-de-la-sante/ids120/, DOI : https://doi.org/10.34746/bcqc-mb09

Résumé

En constante évolution depuis son apparition au milieu du XXème siècle, l’Intelligence Artificielle touche aujourd'hui de nombreux domaines d'activités, tel que la santé.

Celui-ci est au cœur des préoccupations : de nombreux textes réglementaires sont apparus pour encadrer ce domaine d'activités et assurer la sécurité des patients.

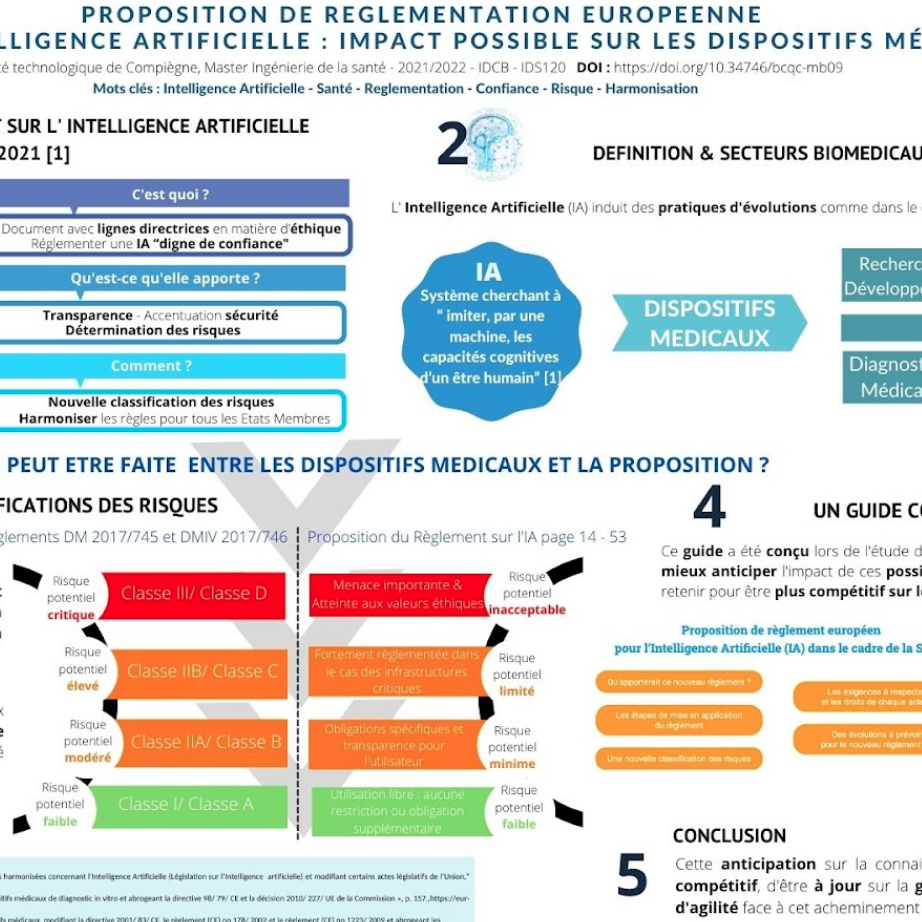

Dans cet axe, la Commission Européenne a publié en avril 2021 un document sur les lignes directrices à respecter, en matière d'exigence, de sécurité et d’éthique, pour obtenir une IA “digne de confiance”. Cette proposition est un support qui permet d’introduire les enjeux et de donner confiance au règlement en encadrant l’IA et ses acteurs pour permettre son utilisation et son développement en toute sécurité au sein de l’Union Européenne.

Dans ce contexte, ce projet a pour objectif d'éclairer fabricants, fournisseurs, utilisateurs et tiers sur les obligations européennes à respecter pour assurer la sécurité du patient et donner confiance à chaque acteur exploitant des systèmes d’IA. La cartographie interactive réalisée permet de résumer les éléments essentiels de ce mémoire.

Abstract

Many fields of activity, such as health. The latter is at the heart of the concerns : numerous regulatory texts have appeared to frame this field of activity and ensure the safety of patients. In this area, the European Commission published in April 2021 a document on the guidelines to be respected, in terms of requirements, safety and ethics, to obtain a "trustworthy" AI. This proposal is a support to introduce the issues and to give confidence to the regulation by framing AI and its actors to allow its use and development safely within the European Union. In this context, this project aims to enlighten manufacturers, suppliers, users and third parties on the European obligations to respect to ensure the safety of the patient and to give confidence to each actor operating AI systems. The interactive map was produced to summarise the key elements of this report.

Téléchargements

Poster

Guide de compréhension de la proposition du règlement européen sur l'Intelligence Artificielle dans le domaine de la Santé

Étude de la proposition de règlement européen pour l'Intelligence Artificielle

Remerciement

Tout d'abord, nous tenons à exprimer nos sincères remerciements envers M. Gilbert Farges, enseignant-chercheur du Master Ingénierie de la Santé, à l'Université de Technologie de Compiègne, qui nous a accompagnés tout au long du semestre sur ce sujet. Ses conseils avisés ainsi que son investissement nous ont motivé et permis de mener à bien cette étude dont le thème était avant-gardiste et très intéressant pour nous.

Nos plus vifs remerciements également à Mme Isabelle Claude et M. Jean-Matthieu Prot, responsables du Master Ingénierie de la Santé, et Mme Béatrice Konig, pour leurs analyses avisées.

Nous remercions également toute l’équipe pédagogique de l’UTC, ayant participé de près ou de loin à notre projet.

Pour finir, nous remercions notre entourage, nous ayant accompagné et supporté moralement tout le long de nos études.

Liste des acronymes

- ANSM : Agence National de Sécurité du Médicament et du produit de santé

- BPI : Banque Publique Investissement

- CEPD : Comité Européen de la Protection des Données

- CGET : Commissariat Général à l'Egalité des Territoires

- CNEDIMTS : Commission Nationale d’Evaluation des Dispositifs Médicaux et des Technologies de Santé

- CNIL : Commission Nationale de l'Informatique et des Libertés

- DGE : Direction Générale des Entreprises

- DM : Dispositif Médical

- DMC : Dispositif Médical Connecté

- DMDIV : Dispositif de Diagnostic Médical In Vitro

- DGE : Direction Générale des Entreprises

- FDA : Food and Drug Administration

- HAS : Haute Autorité de Santé

- IA : Intelligence Artificielle

- LPPR : Liste des Produits et Prestations Remboursables

- RGPD : Règlement Général des Protections et Données

- UE : Union Européenne

Glossaire

- Agence Nationale de Sécurité du Médicament et des produits de santé : Etablissement public administratif placé sous la tutelle du ministère chargé de la Santé. Il agit au nom de l’Etat, au service des patients, afin d’assurer la sécurité des produits de santé et de favoriser l’accès à l’innovation thérapeutique.

- Algorithme : Suite d’instructions ordonnées qui a pour but de trouver un résultat à partir de données connues.

- Big data (mégadonnées) : Combinaison de données structurées, semi structurées et non structurées collectées par des organisations qui peuvent être exploitées pour donner des informations et utilisées dans des projets d’apprentissage automatique (Machine Learning), de modélisation prédictive et d’autres applications analytiques avancées.

- Commission Nationale d'Evaluation des Dispositifs Médicaux et des Technologies de Santé : Commission de la HAS qui évalue les dispositifs médicaux et des actes professionnels en vue de leur remboursement.

- Cefoxitine : Antibiotique Bêta-lactamine de 2éme génération (Céphalosporine).

- Commission Européenne : Institution qui porte et promeut l'intérêt général de l’union. Elle est gardienne des traités.

- Cybersécurité : Ensemble des mesures de sécurité informatique.

- Database : Collection systématique de données.

- Direction Générale des Entreprises : Rattachée au ministère de l’Economie et des Finances, c’est une direction d’administration publique.

- Dispositif médical : Tout instrument, appareil, équipement, matière, produit, ou autre article utilisé seul ou en association, nécessaires au bon fonctionnement de celui-ci, destiné par le fabricant à être utilisé chez l’homme à des fins médicales et dont l’action principale voulue n’est pas obtenue par des moyens pharmacologiques ou immunologiques ni par métabolisme, mais dont la fonction peut être assistée par de tels moyens (Règlement européen 2017/745).

- Dispositif médical de diagnostic in vitro : Tout dispositif médical qui consiste en un réactif, un produit réactif, un matériau d'étalonnage, un matériau de contrôle, une trousse, un instrument, un appareil, un équipement, un logiciel ou un système, utilisé seul ou en association, destiné par le fabricant à être utilisé in vitro dans l'examen d'échantillons provenant du corps humain (Règlement européen 2017/746).

- Distributeur : Toute personne physique ou morale faisant partie de la chaîne d’approvisionnement, autre que le fabricant ou l’importateur, qui met un dispositif à disposition sur le marché, jusqu’au stade de sa mise en service (Règlement 2017/745).

- Haute Autorité de Santé : Autorité publique indépendante à caractère scientifique qui contribue à la régulation du système de santé.

- I2A : Entreprise spécialisée dans le domaine du diagnostic microbiologique.

- Importateur : Toute personne physique ou morale établie dans l’Union qui met un dispositif provenant d’un pays tiers sur le marché de l’Union (Règlement 2017/745).

- Staphylocoque : Bactérie du genre staphylococcus.

Introduction

« La création d'une intelligence artificielle serait le plus grand événement de l'histoire de l'humanité. Mais il pourrait aussi être l'ultime », Stephen Hawking (Web Summit de Lisbonne, 2017)

En constante évolution depuis son apparition au milieu du XXème siècle, l’Intelligence Artificielle est une discipline qui a connu un essor particulièrement fulgurant ces dix dernières années. En effet, les nombreuses avancées technologiques, telles que le deep-learning et les algorithmes, ont eu pour effet de faire regagner en popularité cette discipline quelque peu délaissée [1].

Touchant de nombreux domaines d’activités (santé, militaire, industriel, bancaire, automobile…), elle a récemment été définie par la Commission européenne, de façon globale, comme un “ logiciel pouvant, pour un ensemble donné d’objectifs définis par l’homme, générer des résultats tels que des contenus, des prédictions, des recommandations ou des décisions influençant les environnements avec lesquels il interagit” [2].

A titre d'exemple, en 2020, la start-up new yorkaise Clearview, spécialisée dans la reconnaissance faciale, a scandalisé le monde lorsqu’il a été découvert que pour construire sa base de données, elle avait collecté plus de 3 milliards d’images provenant des réseaux sociaux (Facebook, Google, Twitter…) à l’insu de ses utilisateurs [3].

Sa volonté d’étendre ses services au marché européen, sans avoir pour autant signé l’accord de protection des données conclu entre l’UE et les États-Unis (2016) a rendu réticente les autorités à son entrée dans le marché intérieur. Cet accord soulignant l’obligation des entreprises américaines à protéger les données des utilisateurs européens conformément aux standards européens et aux droits des consommateurs.

En mai 2021, face à la suspicion que certaines de ces données appartiendraient à des ressortissant de l’UE (violation de l’article 4.14 de la RGPD), un groupe d’ONG a porté plainte au nom de plusieurs pays d’Europe, dont la France, contre cette startup [4].

Cet exemple illustre bien l’urgence actuelle, à savoir celle de recadrer notre système juridique, pour qu’il soit plus uniforme. En effet, si manipuler les systèmes d’IA peut générer des risques, impactant ainsi les intérêts et droits protégés par l’UE, il ne faut pas oublier que ses exploits sont multiples et qu’il est fort probable qu’elle continue d’être à l’origine de nombreuses avancées et innovations.

Face à ce constat, un questionnement apparaît : dans une optique d’évolution du marché intérieur, comment associer libre circulation des systèmes IA aux contraintes de sécurité liée à leurs développements, ventes, utilisations… Sans oublier que leurs manipulations impliquent d’étudier les notions de confidentialité, de consentement et de droit d’accès aux données partagées.

Pour répondre à l'intérêt général de sécurité et de libre circulation des biens et services sans restriction au sein de l’UE, une proposition de règlement a récemment été déposée par la Commission Européenne (2021/0106(COD)) [5]. Très générale, celle-ci concerne tous les systèmes d’IA quel que soit leurs domaines d’activités et introduit de ce fait une définition globale de l’IA.

En effet, jusqu’ici le manque d’encadrement faisait que les différents organismes adaptaient leur système en se basant sur leur propre définition. Ce point est l’une des raisons qui a poussé les autorités compétentes à prévoir une définition neutre vis-à-vis des plans technologiques dans une optique de pouvoir résister à l'épreuve du temps tout en tenant compte de l’évolution rapide des technologies et du marché de l’IA .

Partie I : Les impacts de l'Intelligence Artificielle en Santé

1. Généralités sur l’IA

1.1 Définition de l’IA

A ce jour, il n'existe pas de définition largement acceptée de l'Intelligence Artificielle.

John McCarthy, l’un des fondateurs de l’Intelligence Artificielle et inventeur de ce terme, l'a définie en 1956 comme : “La science et l’ingénierie de la fabrication de machines intelligentes”. L’Intelligence Artificielle serait donc la construction de machines intelligentes capables de simuler l'intelligence humaine.

Figure 1 : Décomposition des procédés élémentaires de l’IA (source : auteur) [6].

| IA | Discipline regroupant toutes les techniques et méthodes visant à comprendre et reproduire le fonctionnement du cerveau humain. |

| Machine Learning | Techniques d’apprentissage automatique : les machines ont la capacité d’apprendre automatiquement à exécuter des tâches sans qu’une programmation ait été déterminée au préalable. |

| Deep Learning | Technique particulière de machine learning, le deep learning est une technique d’apprentissage reposant sur le modèle neuronal. Plusieurs couches de neurones artificiels, empilés, imitent le cerveau humain pour résoudre un problème. |

1.2 Les différents types d’IA

L’Intelligence Artificielle peut être classée en sept types en fonction des performances des machines. Pour cela, la figure suivante récapitule les différents types (Figure 2).

Figure 2 : Classification des Types d’Intelligence Artificielle en fonction des performances des machines (source : auteur) [7].

Il est important de rappeler que dans le cadre de la santé, les systèmes d’Intelligence Artificielle sont désormais considérés comme des Dispositifs Médicaux.

En effet, le règlement (UE) 2017/745, relatif aux Dispositifs Médicaux du 5 avril 2017, a élargi la définition du Dispositif Médical : elle introduit désormais dans les fonctions du DM les notions de prédiction et de pronostic relatives aux propriétés auxquelles l'Intelligence Artificielle répond. Ainsi à partir du moment où un logiciel présente “au moins une fonctionnalité permettant l’exploitation des données du patient en vue d’aider le médecin à établir sa prescription, il est qualifié de Dispositif Médical” [8].

2. Le marché de l’IA

Au niveau mondial, selon l’article de Hermann Say, le marché de l’Intelligence Artificielle (IA) s'évalue à plus de 327 milliards de dollars jusqu’en 2021. Il est prévu une croissance exponentielle dont la contribution à l'économie mondiale pourrait atteindre 13 500 milliards de dollars. Les principales raisons pour les entreprises d'investir dans l’IA sont de réduire les coûts, en améliorant la productivité et l'efficacité, d’accroître la qualité des produits et services, d'améliorer le support client, l'efficacité des systèmes d'informations de la technologie et les opérations marketing [9].

Cependant là où, les États-Unis et la Chine sont responsables chaque année d’environ 25 milliards d’euros d’investissement pour l’Intelligence Artificielle, l’UE représente en valeur cumulée, d'après un rapport publié en 2021 par la Commission Européenne et la Banque Européenne d’Investissement, environ 1,5 milliards d’euros [10]. Cette valeur du marché est calculée d'après le nombre de PME ayant reçu un investissement pour développer de l’IA.

Ce marché est partagé dans le monde : les Etats-Unis (47,8 %) se place comme principal acteur, suivi par la Chine (19.7%) et l'Europe (19.3%). Il est à noter que parmi les pays de l’Europe, la part du marché prise par le Royaume-Uni n'est pas négligeable (7.6%) (Figure 3).

Figure 3 : Nombre de PME dans les principales puissances mondiales Intelligence Artificielle (source auteur inspiré par Rapport “Intelligence artificielle, blockchain et l'avenir de l'Europe”) [10].

Le comportement exponentiel des revenus en IA dans le secteur de la Santé dans le monde a été développé dans le rapport “Intelligence Artificielle - État de l’art et perspectives pour la France” par le ministère de l’Économie et des Finances (Figure 4). A la fin de l'année 2021, un taux de croissance de 55%, soit 6 662,2 millions de dollars, est attendu pour l’IA [11].

D'après un rapport de la Banque Publique d’Investissement (BPI France), les données du cabinet de conseil Frost & Sullivan montre que la valeur du marché mondial de la Santé numérique, incluant l’IA, devrait atteindre 234,5 milliards de dollars d’ici 2023 [12]. Cette croissance s'explique essentiellement par des besoins liés au vieillissement de la population et à la forte augmentation des maladies chroniques.

Figure 4 : Évolution des revenues en IA dans le secteur de la santé (source auteur inspiré par le rapport “Intelligence artificielle - État de l’art et perspectives pour la France” ) [11].

En France, les industries de la Santé regroupent 211 000 salariés directs dont 104 000 appartenant à l’industrie du médicament [11]. L'investissement dans le marché de la Santé est associé à l’utilisation des systèmes d'IA dans la mesure où ceux-ci représentent un potentiel économique important. Les principales entreprises du secteur ont généré un chiffre d'affaires de près de 800 millions d’euros en 2019 et la croissance de l’IA pourrait représenter 180 000 emplois directs et indirects d’ici 2030 [13].

La Direction Générale des Entreprises (DGE), qui pilote le volet économique de la stratégie nationale pour l’IA, le Commissariat Général à l'Egalité des Territoires (CGET) et Tech’in France (comportant les syndicats professionnels français de l’industrie du numérique) ont établi un plan d'action divisé en 4 axes :

- Mettre la IA au service de l'économie francilienne et de son industrie.

- Conforter le Leadership et l'attractivité internationale de la France en matière d’ IA.

- Permettre une ouverture technologique sur les filières régionales prioritaires

- Piloter et évaluer.

Afin de déployer cette stratégie, un budget total de 20 millions d'euros a été attribué pour le développement de l’IA dans 5 secteurs différents, dont celui de la Santé [11].

Concernant l’IA en tant qu’entité et sa place dans le secteur européen, la France jusqu'en 2018 était le premier pays européen et Paris la première ville européenne par rapport au développement de PME selon le rapport Roland Berger - Asgard [11]. Toujours en France, selon le rapport de l'article de Hermann Say, le développement représente aujourd'hui 23%, confirmant ainsi la croissance de ce mouvement sur le territoire [14].

Un grand contributeur de ce mouvement est la BPI qui a financé environ 23 millions d'euros en 2019 dans le secteur de la Santé. La conséquence directe de cet investissement est l’augmentation du nombre de startups françaises, qui a presque doublé entre 2019 et 2020 : 191 startups en 2020 [15].

Figure 5 : Paysage entrepreneurial français d’IA dans le secteur de la santé (Source auteur inspiré par BPI France).

Ces valeurs permettent de mettre en évidence la croissance exponentielle dans le marché de l’Intelligence Artificielle, de l’investissement et des revenus obtenus. En effet, les pays leaders du mouvement du développement de l’IA changent constamment.

3. Exemples d’IA dans la santé

3.1 Les applications en Santé de l’IA

Les applications de l’Intelligence Artificielle dans le secteur de la Santé est un domaine de recherche en pleine expansion et promis à un grand avenir. Cette nouvelle technologie a amélioré la prise en charge des patients et a réduit les coûts d'hospitalisation. Elle a également facilité le travail des équipes médicales. La figure suivante résume l’ensemble de ses applications courantes au cours des 10 dernières années.

Figure 6 : Domaines d’application de l’IA en santé [16] (source : auteur)

3.2 Exemples d’applications

Médecine personnalisée - IBM WATSON FOR GENOMICS

WATSON FOR GENOMICS est un programme d’Intelligence Artificielle créé par IBM.

Grâce à l'informatique cognitive, cet outil d’Intelligence Artificielle peut en quelques minutes interpréter les données de séquençage génomique d’une tumeur à la recherche d’une mutation pour ensuite proposer un traitement personnalisé selon la mutation détectée [17].

Figure 7 : Logiciel d’IBM Watson for Genomics (source : IBM Watson for Genomics) [17]

Diagnostic -IDx-DR

IDx-DR est un système d’Intelligence Artificielle développé par la startup IDx.

Il est le premier appareil à être autorisé à faire un diagnostic médical par la Food and Drug Administration (équivalent de l’ANSM pour les Etats-Unis).

Cet algorithme de diagnostic détecte précocement et diagnostique les signes de la rétinopathie diabétique grâce à des images rétiniennes [18].

Figure 8 : Le système IDx-DR en action (source : IDx-DR) [19]

Prévention - QCovid

QCovid est un algorithme développé par des chercheurs de l’Université d’Oxford.

C’est un outil de calcul du risque d'hospitalisation ou de décès lié à la Covid-19. Il utilise des facteurs tels que l'âge, le sexe, l'origine ethnique et les antécédents médicaux pour générer une évaluation détaillée des risques.

Une autre version de cet algorithme a été développée en 2021 pour calculer le risque d'hospitalisations ou de décès lié à la Covid-19 après une ou deux doses de vaccin [20].

Figure 9 : Page d'accueil du QCovid risk calculator (source : QCovid) [18]

Prévention - WOEBOT

WOEBOT est un chatbot d'Intelligence Artificielle conçu par un groupe de psychologues de l'Université de Stanford en 2017.

Ce chatbot aide à surveiller la santé mentale de ses utilisateurs grâce à une expertise psychologique, principalement en Thérapie Cognitivo-Comportementale (TCC) et propose des conseils pertinents pour surmonter leurs difficultés.

Les conversations quotidiennes sont brèves et peuvent s’accompagner de vidéos [21].

Figure 10 : Exemple de discussion du chatbot WOEBOT (source : WOEBOT) [22]

Chirurgie Robotique - Senhance

Le système chirurgical Senhance est un système chirurgical robotisé de la société Asensus Surgical.

Il est destiné à la réalisation de la chirurgie mini-invasive. C’est la première et la seule plateforme laparoscopique numérique.

Équipé d'un système d'oculométrie, il permet au chirurgien de contrôler la vision durant l’intervention sans s'arrêter pour repositionner la caméra et d’une rétroaction haptique qui capte la force appliquée pour minimiser les traumatismes.

Il permet également au chirurgien de maintenir une posture assise ergonomique tout au long de la procédure. Ce système stabilise les instruments et permet au chirurgien de repositionner facilement ses mains pendant la chirurgie pour éviter toute position inconfortable pour effectuer des actes délicats.

Il est le seul système chirurgical robotisé qui offre des instruments de 3mm de diamètre [23].

Figure 11 : Le robot chirurgical Senhance (source : Senhance) [23]

Médecine physique et de réadaptation - Lokomat

Lokomat est un système robotisé par un exosquelette de membres inférieurs électro-mécanisé d’entraînement à la marche permettant une thérapie locomotrice efficace et motivante pour les patients souffrant d’un déficit moteur à la suite d’une atteinte neurologique notamment les séquelles de l' AVC [24]..

Figure 12 : Exosquelette Lokomat (source : Lokomat) [25]

4. Risques et Limites de l’IA en Santé

L’IA touche plusieurs domaines en Santé (diagnostic, traitement, « management patient»…), et est donc fortement mise en avant dans les établissements de santé.

Cependant sa manipulation n’est pas sans risque et des incidents sont, comme pour toutes technologies, possibles.

Il est donc de la responsabilité de tous (industriels, autorités réglementaires, utilisateurs…) de limiter ces risques pour diminuer la probabilité qu’un accident arrive.

4.1 Définition du risque

Pour le prévenir, en mettant en place les dispositions nécessaires, il est indispensable de définir, dans un premier temps, ce qu’est un « risque ».

La complexité de sa définition provient du fait que selon les contextes et les points de vue, celle-ci peut varier.

Aussi il peut être défini comme un « Danger éventuel, plus ou moins prévisible, inhérent à une situation ou à une activité » (Cnrtl) ou encore « (‘L) éventualité d'un événement futur, incertain ou d'un terme indéterminé, ne dépendant pas exclusivement de la volonté des parties et pouvant causer la perte d'un objet ou tout autre dommage » (Ineris) [26], [27].

S’il est souvent associé à son synonyme « danger », il ne faut pas les confondre dans la mesure où, même s’ils paraissent interchangeables, la notion de risque amène une notion d’incertitude mesurable (probabilité) à un effet qui paraîtrait autrement avéré.

Par ailleurs, généralement la société moderne lui associe deux sens distincts : « la possibilité d’un danger et en même temps les conséquences potentielles occasionnées par ce danger ».

Dans le premier, l’accent est mis sur la source du risque, dans le second, sur la cible exposée à celui-ci : le risque comporte donc deux notions, celle de danger et celle d’exposition.

Pour prévenir et gérer les risques, il faut considérer un événement potentiellement dangereux comme source de risque, « que s’il est susceptible de porter atteinte à des enjeux humains, environnementaux, économiques (ou) culturels ».

La mesure du risque se fait en évaluant la gravité associée aux dangers potentiels.

En fonction de ces critères, le risque sera caractérisé comme étant acceptable, inacceptable (auquel cas des actions devront être menées) et entre les deux, considéré comme « toléré » (ou acceptable sous contrôle) (Figure 8).

Figure 8 : Courbe de Farmer (source : ©Académie d'Aix-Marseille ).

Dans le domaine médical, est considéré comme un risque tout élément ayant une incidence sur la santé du patient et/ou altérant son état général (handicap, brûlure, décès…).

Rappel brève de la classification de risque des DM (Règlement 2017/745) :

La nouvelle réglementation européenne 2017/745, classe les DM selon quatre niveaux de risque : classe I, classe IIa, classe IIb et classe III. Cette classification prend en compte la durée d’utilisation (temporaire, court et long terme), le caractère potentiellement invasif et le type d’invasivité, la possibilité ou non de réutilisation, la visée thérapeutique ou diagnostique et la partie du corps concernée. Plus particulièrement, le logiciel commandant un dispositif ou agissant sur son utilisation, relève de la même classe que le dispositif. Si le logiciel est indépendant de tout autre dispositif, il est classé en tant que tel. (Ex : Règle 11, les logiciels destinés à fournir des informations utilisées pour prendre des décisions à des fins thérapeutiques ou diagnostiques sont considérés DM de classe IIa).

4.2 Exemples d’incidents de l’IA en Santé

Diagnostic : L’exemple d’IBM Watson

A la base créée pour répondre à des questions , la technologie Watson a été adaptée, dans le domaine de la Santé, pour analyser toutes les données relatives aux patients afin d’aider le médecin en proposant un diagnostic et un traitement thérapeutique.

Bien vu au départ, l’engouement s'est néanmoins peu à peu affaibli [28]. Le manque d’apport pertinent comparé au jugement des médecins et les erreurs de diagnostic récurrentes ont peu à peu repoussé les professionnels de la santé : « La technologie Watson était autrefois synonyme de docteur artificiel ».

Établi en 2013, le projet « Watson for Oncology » annulé, entraînant une perte colossale de 62 millions de dollars, illustre cette perte d’engouement [29]. La cause étant des recommandations inutilisables car incorrectes voire même très dangereuses pour le patient. L’un des plus connus : le logiciel recommandant aux médecins de donner à un patient hémorragique un médicament qui aggraverait ses saignements.

D’après StatNews, site d'information américain sur la Santé, ces erreurs proviendraient d’un mauvais apprentissage de l’algorithme : les ingénieurs auraient utilisé un faible nombre de données provenant de patients fictifs.

Chirurgie Robotique : L’exemple du Robot DA VINCI

Véritable révolution du début des années 2000 , le robot DA VINCI a pour vocation d’assister le chirurgien pour réaliser une intervention chirurgicale « non-invasive ». Il est utile pour des localisations délicates telles que la prostate ou encore pour réaliser des hystérectomies. Ses promesses de rétablissement incomparables aux chirurgies invasives l'ont rendue d’autant plus attractive.

En 2018 était recensé plus de 4 500 robots déployés dans le monde, parmi lesquels 125 en France (« répartis à 50-50 entre établissements publics et privés ») (Figaro).

Le problème majeur de ce robot est le nombre d'incidents qu’on lui associe. Aux Etats-Unis, celui-ci a fortement explosé entre 2012 et 2014 : d’environ 1 600 cas recensés en (2012) le nombre de cas est passé à 6 000 (2013-2014). La justice américaine aura même été saisie de plus de 3 000 plaintes (2013).

D’après la FDA, cette explosion serait dûe au fait que la société américaine n’avait pas annoncé tous les cas d’incidents : c’est seulement suite à leur rapport et la médiatisation des premières plaintes que le nombre de cas répertoriés a explosé. En Europe, l’accord sur la déclaration d’incidents médicaux reste néanmoins une mesure de garantie supplémentaire.

Les causes principales seraient, outre la formation et l'expérience des chirurgiens qui les utilisent, dûes à des défaillances techniques et des problèmes d’isolation pour certains composants.

Aussi les incidents relevés vont, dans le cadre de la défaillance du système, de la perte des enregistrements vidéo des procédures ou du contrôle de l’appareil, à des brûlures (193 patients recensés entre 2000 et 2021) voire une exposition à des éclats de composants en cas d’étincelles pendant l’opération [30]. En 2015, un rapport du MIT (Massachusetts Institute of Technology) expliquait que le robot Da Vinci était la cause de 144 décès aux USA.

Malgré ces points en 2021 ces robots continuent d’être utilisés et ceux pour plusieurs raisons :

- Certains considèrent les cas recensés comme minimes comparé aux apports démontrés : le chirurgien David Samadi, premier chirurgien ayant effectué aux Etats-Unis une intervention de chirurgie robotique assistée sur la prostate, a réalisé avec succès plus de 4 500 opérations (chiffre de 2015).

- Les incidents sont majoritairement attribués aux personnes qui manipulent ces appareils : « Ce n'est pas le robot qui est dangereux mais le chirurgien qui l'utilise », Dr. David Samadi (interview sur la chaîne FOX en 2013).

- L’évolution de sa pratique initiale (urologie adulte) fait qu’après avoir été adaptée à une multitude de spécificités, « chirurgies digestives adultes, thoraciques, vasculaires et gynécologiques », elle est employée aujourd’hui dans les services pédiatriques. En juin 2021, pour la 1ère fois cet outil a même été utilisé dans le service pédiatrique du CHU Dijon Bourgogne [31].

Médecine Personnalisée [32]

L’objectif de la médecine personnalisée est de prendre en compte l’individu dans son entièreté (métabolisme, environnement et mode de vie compris) pour traiter et prévenir de façon précise des pathologies.

Dans une interview accordée au magazine Forbes, Anas Dogui, entrepreneur et fondateur de la start-up “Imageens”, spécialisée dans les Dispositifs Médicaux, explique que le développement de l'IA est la clé qui permettra à la médecine d’être de plus en plus prédictive et personnalisée [32].

En effet, face au besoin grandissant d’exploiter le nombre de plus en plus élevé de données de Santé (Big Data), que l’Homme seul ne peut pas analyser l’IA, transposable à tous les domaines, s’est imposée comme solution de choix. Cette augmentation est une conséquence indirecte du développement des technologies de santé (protocole d’imagerie, outils de monitorage…).

Si à ce stade des risques autres que ceux associés à l’IA n’ont pas été identifiés pour ce type de médecine, des limites ont néanmoins été établies pour [33]:

- Chaque individu, déterminer un schéma médical lui étant propre. L’algorithme se fonde sur une base de données alimentée par une multitude d'individus ;

- Assurer la fiabilité des recommandations données pour le système d’IA (correcte, amenant un apport positif, sans biais …) ;

- Tester les systèmes en conditions réelles sans entraver la santé et la sécurité des patients (situation réelle : apprentissage concret de l’algorithme) ;

- L’identification des paramètres ayant amené l’IA à tel raisonnement (relation causale) et la justification des actions qu’elle recommande (indispensable pour la confiance décisionnelle). Il faudrait que l’IA ne fasse pas de simples associations/prédictions mais prennent en compte tous les facteurs ayant une influence (âge, dangerosité …).

Ces avis et ces incidents permettent donc de mettre en évidence un fait incontestable : il existe des limites, l’utilisation de l’IA n’est pas sans règles. Chaque acteur qui interagit avec doit en prendre compte.

Exemples d’incidents

- Diagnostic - Watson for Oncolongy

Incidents : Erreurs de jugement, mauvaises et dangereuses recommandations

Risque : Décès des patients

Limites : Exploitation Des DATAS

Indicateurs : « Perte colossale de 62 Millions de Dollars »

- Chirurgie Robotique - Robot Da Vinci

Incidents : Décès des Patients

Risques : Incidents répétés non détectés

Limites : Formation et Expérience du chirurgienIndicateurs : « 144 décès en 2015 » (USA)

4.3 Limites de l’IA

La limite la plus « évidente » est celle de la responsabilité : en cas de mauvais diagnostic, qui tenir responsable (l’Homme ou la machine) et quels arguments avancés en faveur de chacun ? Pénalement, il n’est pas possible de punir une machine, Quelque soit les arguments avancés, l’Homme sera-t-il toujours tenu pour responsable ? A l’heure actuelle, cette position est favorisée.

Concernant la délimitation des rôles de chacun, il faut bien comprendre qu’à la base, les systèmes d’IA restent des outils d’aide. Ils ne doivent donc pas entraver le travail des professionnels qui l’utilisent et par conséquent, les remplacer.

Une autre limite est celle de la confiance : les patients ont-ils confiance en l’IA ? En son diagnostic ? Si oui, jusqu’à quel point ? Qu’en est-il de leur relation avec les professionnels de santé ? Sera-t-elle impactée ?

D’après une étude publiée sur le site de MBAMCI (2019) non seulement « 88% des Français estiment ne pas être suffisamment informés des impacts et usages de l’IA » mais également seul « ¼ (…) est prêt à lui faire confiance si elle est utilisée comme support des médecins ». Cette notion de confiance est donc non négligeable et doit être prise en compte par les acteurs de la santé [34].

La notion d’éthique [35] : Pour maintenir une relation humaine, l’introduction des systèmes d’IA en Santé doit intégrer des notions d’éthique lors de la prise en charge des patients. En sachant qu’il est possible que les décisions prises par l’algorithme ne soient pas adaptées, il est indispensable que, non seulement celui-ci comprenne son fonctionnement mais également qu’il puisse expliquer le processus de décisions entrepris de façon claire et concise (obligation déontologique, « le médecin doit pouvoir expliquer à son patient le raisonnement d’un diagnostic », permettant dans un même temps de rassurer le patient).

Le cadre de régulation et les réglementations adoptées auront une importance majeure dans la tenue de cette notion d’éthique : réguler sans entraver.

Une limite toute aussi importante est celle de l’exploitation des données : les données recueillies ne l'ont pas été pour être utilisées, en première intension, de cette façon, et ne devraient donc pas forcément être toutes utilisées. A cette limite peut s’ajouter la notion de consentement.

L’échec du développement de systèmes IA utiles lors de la pandémie COVID-19, malgré la masse de données récoltées, en est la preuve même [36]. Malgré les nombreux essais, les chercheurs n’ont pas réussi à développer des systèmes d’IA permettant d’aider les médecins à lutter contre la pandémie COVID-19 (en analysant des images et en apportant un avis quant aux décisions à mener).

Là où les systèmes IA auraient dû apporter leurs preuves, les échecs fulgurants ont fait qu’elles se sont révélées inutiles : en raison des datas inconnues, de basse qualité voire même « corrompues » pour être utilisées au développement de ces outils. Sans compter les cas où ces mêmes datas ont été utilisées plusieurs fois par le même logiciel, avec des indications (scanner debout/assis) associées par les algorithmes à un niveau de gravité. Autre exemple où l’algorithme, originellement libre de jugement, a pris en compte l’avis des médecins ayant délivré le diagnostic pour déclarer le pronostic.

Ces limites imposent un fait important : l’utilisateur prend appui sur l’IA qui doit rester un outil d’aide et non pas le suppléer (s’applique à l'établissement de santé, avec la fonction du soignant). Dans cette optique, les formations et l’expérience des opérateurs vont être d’une importance clé. Les industriels eux devront s’assurer que les outils mis sur le marché soit le plus fiable possible pour limiter toute marge d’erreur associée à une défaillance des systèmes en situations réelles. Outre les incidents, le risque majeur est donc que ces limites ne soient pas respectées.

Pour faciliter cette démarche indispensable, permettant la sécurité d’emploi de ces outils sur le marché, les industriels peuvent se reposer sur les systèmes de loi existant.

A l’échelle européenne, en 2021 la Commission Européenne a publié une proposition de règlement visant à améliorer le fonctionnement du marché intérieur de l’IA notamment en uniformisant la sécurité pour répondre à l’intérêt général, la libre circulation des services et bien par exemple, et ce, sans « restrictions » imposées par les États membres.

Dans ce cadre, la partie suivante introduira cette proposition, ses intérêts et pourquoi il serait intéressant qu’elle soit validée .

Partie II : Exigences de l’IA en Santé en terme de sécurité associée à la réglementation européenne

1. La réglementation de l’IA en Europe dans la Santé

1.1 Acteurs de la réglementation IA en Europe

Le Conseil Européen

Missions principales :

Oriente et priorise les politiques de l’UE, notamment les sujets non traitables à l’échelle intergouvernementale.

Compositions :

- Chefs d’État et de gouvernement des pays de l’UE

Le président du Conseil européen

Le président de la Commission européenne

- La Commission Européenne

Missions principales :

Promouvoir l'intérêt général de l'UE avec des propositions.

Veiller à l’application de ces textes législatifs.

Appliquer les politiques et le budget de l'UE.

Compositions :

Direction politique : la présidente + « Collège » avec équipe de commissaires (un par État membre)

Gestion courante des affaires de la Commission : comporte des services appelés « directions générales » (DG)

- Le Parlement Européen

Missions principales :

Compétences législatives, budgétaires et de surveillance.

Compositions :

Le président du parlement

705 députés (nombre de sièges variés selon chaque Etat Membre)

- Le Conseil de l’UE

Missions principales :

Permettre de porter les voix directement des Etats Membres de l’UE

Adopter la législation et coordonner les politiques de l’UE.

Compositions :

Ministres nationaux, en fonction des domaines politiques traités [37].

Le but de l’Union Européenne (UE) est de coordonner des décisions de divers domaines de manière unanime entre les Etats Membres afin de promouvoir les avancées et d’améliorer la cohésion des États [38]. L’UE est structurée par plusieurs organismes, réparties de manière hiérarchique selon un schéma défini, notamment dans le cadre d’une proposition (Figure 11).

Figure 11 : Acteurs principaux de l’Union Européenne entrant dans le cadre de la proposition (source : auteur).

Dans cette situation de proposition, les organismes ont un rôle imminent et s’inscrivent dans un devoir de bien fondé :

- D’abord, le Conseil de l’Europe va soulever une thématique avec une problématique qui, une fois résolue même partiellement, aura des avantages sur les citoyens européens : exemple ici avec la réglementation de l’IA.

- La Commission Européenne se charge alors d’établir une proposition, forte en arguments : ici pour l’IA, elle soulève les termes de sécurité et leurs détails selon divers domaines. Elle va être appuyée notamment par le contrôleur européen de la protection européenne.

- Ensuite débute la lecture de la proposition : elle commence par le Parlement européen qui émet un avis sur cette dernière et l’envoie au Conseil de l’UE. Si tous les 2 sont d' accord, alors il y a adoption de la demande. Dans le cas contraire, il y a jusqu'à 2 relectures possibles à l’issue de quoi, un tiers intervient : il s’agit du comité de conciliation qui prendra la décision finale.

Autre point à souligner, le nouveau Règlement Européen 2017/745 pour les Dispositifs Médicaux (DM) [39] et le nouveau Règlement Européen 2017/746 pour les Dispositif de diagnostic médical in vitro (DMDIV) [40]:

- Mise en application depuis mai 2021, ils restructurent la définition initiale du DM en précisant notamment l’inventaire des DM utilisant de l’IA (cf. partie I) et leur classification.

- Encore nouveau et assez compliqué à répertorier, il faut bien prendre en compte les divers catégories qui comprennent de l’IA (Dispositif Médical Connecté, logiciel, robots, bases de données …). Le but étant de les classer de la manière la plus précise possible selon leur risque.

- Pour ces technologies récentes, afin de les considérer comme “solution fonctionnelle”, il en va de la responsabilité des fabricants de considérer le DM dans toute son intégrité [41].

1.2 Acteurs de la réglementation en France

- L’ Agence Nationale de Sécurité des Médicaments et des produits de Santé (ANSM)

A ce jour, l’ANSM apporte des avis de sécurité et de surveillance sur certains produits utilisant l’IA et un dossier thématique sur l’IA utilisé durant la crise Covid-19 [42].

La position de l’ANSM face à la place de l’IA en Santé est qu’ “il n’est pas envisageable à ce jour de les (DM avec IA) intégrer à cette classification sans plus de précision sur la destination (ou la revendication) fixée par le fabricant de la solution numérique. En effet, les logiciels et applications utilisés dans le champ de la santé ne relèvent pas tous du statut de DM ou de DM DIV” [43].

L’ANSM stipule donc qu’il faut une évaluation au cas par cas pour chaque produit utilisant une IA. Leur classification de manière générale ne pourrait pas être bénéfique car elle ne préciserait pas toutes les spécificités/fonctionnalités de chaque produit.

Il est à noter que dans le cadre d’une utilisation de solution numérique, “le risque [...] n’est pas un critère de qualification” [43]. A la différence des règlements européens (cf partie II.a.), où le risque est un critère fondamental de classification pour les DM et DMDIV (annexes VIII des règlements 2017/745 et 2017/746).

- La Haute Autorité de Santé (HAS) :

La mission de la HAS est de faire profiter au plus vite les patients de ces nouvelles technologies. Cela passe par leur mission première qu’est la prise en charge.Pour être transparent envers les patients mais également envers les fabricants, il doit être connu comment sont évalués ces produits.

En novembre 2020, la HAS a tenu un webinaire sur le thème “DM & Intelligence Intelligence artificielle : quelles spécificités pour l'évaluation ?” [44]. Parmi les informations échangées, 2 grands axes ont été expliqués : les principes de l’évaluation et les éléments spécifiques pour déposer un dossier d’un DM comprenant de l’IA.

Pour les principes d’évaluation, intervenants après le marquage CE et sollicités par le fabricant [45] :

- La Commission Nationale d’Evaluation des Dispositifs Médicaux et des Technologies de Santé (CNEDIMTS) va évaluer selon des critères précis toutes les informations apportées et répertoriées dans le dossier soumis pour la demande de remboursement. Si le remboursement est accepté, il entre alors dans la Liste des Produits et Prestations Remboursés (LPPR).

- Le forfait innovation proposé par la HAS peut être utilisé pour tout fabricant qui juge son produit comme “hors prise en charge de droit commun”. Pour autant, les critères réglementaires sont les mêmes que ceux étudiés pour un dossier “classique”.

- Exemple : à exclure de la prise en charge de droit commun les DM liés à l’IA à usage réservé aux professionnels de santé. Le forfait d’innovation peut ainsi être utilisé.

Evidemment, tout DM n’ayant pas de finalité médicale déclarée n'entrent pas dans les DM soumis à cette évaluation (l’exemple concret est la montre connectée).

Pour les éléments spécifiques du dossier d’un DM lié à l’IA :

- Il est nécessaire de posséder des informations spécifiques de ces technologies pour appréhender les fonctionnalités : les procédés d’apprentissage automatique (depuis entraînement de données) notamment.

- Une grille descriptive de 42 items en 4 domaines clés a été adoptée :

- Finalité d’usage : population visée, fonctionnement et emploi du DM ;

- Données : description données d’entrée et de sortie, informations entraînement pour l’IA

- Modèle : type et modalités d’interventions de l’Homme

- Caractéristiques fonctionnelles : conséquences cliniques et techniques avec la performance, la robustesse du système ou encore l’interprétabilité.

Cette grille se veut évolutive : aucune obligation de remplir tous les champs si ceux-ci ne correspondent.

Actuellement, dans le cas des dispositifs avec IA, la HAS fait souvent appel à un cabinet d’experts sur l’IA. Celui-ci est indépendant de tout intérêt et transparent dans leurs consultations. Cette aide permet d’aborder les dossiers soumis de la manière la plus juste possible.

En février 2021, selon leur finalité d’usage, la HAS a mis en ligne une classification pour les solutions numériques utilisées pour les soins médicaux ou paramédicaux. Elle se base sur 4 niveaux [43]:

- NIVEAU A : outil service support soin et parcours de soins

- NIVEAU B : outil informations générales sur l’utilisateur, formations et supports

- NIVEAU C : outil d’aide pour la prévention, aide au quotidien ou encore pour le dépistage et les diagnostics.

- NIVEAU D : gestion autonome de la décision

- Règlement général sur la protection des données (RGPD) :

Le RGPD est d’après, le règlement 2016/679, relatif à la “protection des personnes physiques à l'égard du traitement des données à caractère personnel et à la libre circulation de ces données “ [46]. Il présente en 11 chapitres les droits et obligations en termes de sécurité et de traitement de données, de transparence d’autorités et de dispositions.

En France, c’est la Commission Nationale de l'Informatique et des Libertés (CNIL) qui veille au respect du RGPD et accompagne l’innovation tout en préservant les libertés individuelles.

2. La proposition du règlement européen sur l’IA

2.1 D’une réflexion éthique de l’UE à une proposition de règlement européen sur l’IA

Au cours des années, l'UE s'est de plus en plus focalisée sur comment elle peut, dans le cadre de l'IA, assurer la protection de ses citoyens.

Dans cet axe, la Commission Européenne a rédigé un document sur les lignes directrices à respecter, en matière d’éthique, pour obtenir une IA “digne de confiance” [47]. Pour qu’une IA soit “digne de confiance”, plusieurs droits fondamentaux doivent être respectés :

- Le respect de l’autonomie humaine ;

- La prévention de toute atteinte ;

- Équité ;

- Applicabilité.

Ces droits peuvent être transposés en bonne pratique à adopter pour la conception d’une IA :

- L’action humaine et le contrôle humain ;

- La robustesse technique et sécuritaire ;

- Le respect de la vie privée et la gouvernance des données ;

- La transparence ;

- La diversité, non discriminante et l’équité ;

- Le bien-être social et environnemental ;

- La responsabilité.

Dans la continuité de ces bonnes pratiques, la Commission Européenne poursuit sa démarche en mettant en œuvre un projet de réglementation et d’actions en faveur de l’excellence et de la confiance dans l’IA.

Le 21 Avril 2021 une proposition de règlement européen sur l’IA a été publiée.

Actuellement, la date de mise en vigueur du texte n’a pas été précisée. Cependant, dans le cas où la proposition serait validée, le règlement rentrerait en vigueur, 20 jours après la publication au Journal Officiel de l’Union Européenne. Dans un deuxième temps, 12 mois après l’entrée en vigueur du texte, l’Article 71 correspondant aux sanctions en cas de non suivi du règlement sera applicable. Enfin, l’ensemble du règlement sera applicable 24 mois après la mise en vigueur (Figure 12).

D’autre part, les systèmes d’IA ayant déjà été mis sur le marché devront respecter le règlement dans le cas d’une IA à haut risque. L’annexe III liste l’ensemble des IA qui sont considérés par le règlement comme à haut risque. La Commission européenne se donne le droit de réévaluer cette liste chaque année. Également, un rapport d’évaluation devra être transmis par les Etats membres portant sur les incidents et les risques rencontrés par les IA mises sur le marché. En conséquence, une réévaluation du règlement pourra être envisagée. Ce rapport et ce réexamen interviendra dans les trois premières années à partir de la mise en application puis sera reconduit tous les quatre ans [5].

Figure 12 : Frise chronologique récapitulative de la régulation de l’IA en Europe (source : auteurs).

2.2 Les objectifs du règlement

L’objectif de la Commission européenne en introduisant cette proposition de règlement est, outre l’encadrement de l’IA, de faire évoluer le marché intérieur au bénéfice de tous. En effet, la vitesse à laquelle elle évolue et ses nombreuses découvertes et innovations font qu’il est fort probable que, dans les années qui suivent, elle impacte une grande partie de la population mondiale.

Dans sa proposition, la Commission européenne introduit le terme de « Règle Harmonisée ». Celle-ci permet d’expliciter à quel point il est important d’harmoniser les règles existantes concernant les systèmes d’ IA, leurs manipulations … dans la mesure où c’est une discipline “relativement” innovante, évoluant constamment et à laquelle les différents partis concernés ne peuvent que se référer. Pour lier les différents textes juridiques européens , de nombreux amendements existent. Ils permettent de lier et de faire référence à d'autres règlements européens existants.

A noter qu’à ce jour, aucun amendement sur la réglementation européenne des DM 2017/745 ou des diagnostics in vitro 2017/746 n’a été réalisé.

Elle indique également qu’il faudrait harmoniser la législation : le cadre juridique, existant et à venir, définit les termes importants (systèmes haut risque, intelligence artificielle…) et exprime l’importance d’avoir des données qui permettent d’identifier comment fonctionnent ces IA. Cela a pour but qu’il n’y ait plus d'ambiguïté et qu’en cas de non-respect du règlement, les partis concernés puissent être sanctionnés.

Cette proposition est un support qui permet d’introduire les enjeux et de donner confiance au probable règlement en encadrant l’IA et ses acteurs pour permettre une utilisation et un développement en toute sécurité au sein de l’Union Européenne [5].

2.3 Nouvelle Classification des Risques des systèmes d’IA

Dans le domaine de la Santé, les DM ont une place très importante. Concernés par la nouvelle réglementation 2017/745 et 2017/746, les systèmes d’IA corrélés aux DM sont classés systèmes à haut risque.

L’une des problématiques principales de cette proposition est de répondre à l’intérêt général de sécurité en protégeant les intérêts et droits protégés par le droit de l’UE.

En réalisant, pour la première fois, une approche fondée sur les risques, la Commission se dit vouloir établir les règles contraignantes des systèmes IA.

Dans ce contexte, il paraît pertinent d’introduire la classification de risques de l’IA et de définir ce qu’est un système IA à haut risque, dans la mesure où le projet de règlement les cible spécifiquement.

L’article 5 de la proposition introduit 4 niveaux de risque :

- Risque inacceptable : la Commission européenne interdit la mise sur le marché, la mise en service et l’utilisation des systèmes d’IA dont le niveau de risque les place comme menace importante pour la sécurité, le droit des personnes et les moyens de subsistance des individus et porte ainsi atteinte aux règles d’éthiques définies par le Parlement Européen.

Dans ce cadre sont notamment interdits les systèmes d’IA qui évaluent et classent les personnes en fonction de leurs caractéristiques personnelles et/ou personnes entraînant un traitement préjudiciable.

- Risque élevé : L’utilisation de ce type de systèmes d’IA est fortement réglementée. La Commission européenne introduit dans la proposition de règlement de nombreuses règles et exigences. Le système d’IA, pour qu’il puisse circuler et être utilisé, doit avoir attesté de sa conformité aux exigences qui le concerne.

Parmi les nombreuses exigences auxquelles sont soumises les systèmes d’IA, il faut que :

- Soit établi et mis en œuvre la documentation technique, avant la mise sur le marché et la maintenance d’un système de gestion de risque ;

- Soit enregistré dans la base de données de l’UE, qui est établie et gérée par la Commission européenne ;

- L’évaluation de conformités soit réalisée par un tiers (ON) ;

- Des personnes physiques aient reçu la responsabilité de superviser le système IA au moment de sa mise sur le marché et tout le long de sa période d’utilisation ;

- Le système d’IA ait un niveau approprié de robustesse, d’exactitude, de cybersécurité et de cohérence pour garantir sa sécurité (facteurs internes et externes).

La liste exhaustive des domaines utilisant des systèmes d’IA à haut risque comprend les infrastructures critiques (systèmes utilisés comme composant de sécurité dans la gestion et l’exploitation des trafics routiers, des établissements de santé) ou encore les systèmes permettant l’identification et le maintien de l’ordre (identification biométrique à distance « en temps réel »).

- Risque limité : Dans ce cadre, la Commission européenne prévoit que les systèmes d’IA appliquent des obligations spécifiques en matière de transparence. Il est indispensable que les utilisateurs soient informés des risques potentiels engendrés par leurs utilisations et que les contenus qu’ils consultent ont été générés par des moyens automatisés (documentation et instruction claires et concises).

- Risque minime : Vis-à-vis de la proposition, aucune restriction ou obligation supplémentaire n’est prévue (conforme à la législation déjà existante). Cependant puisque la majorité des systèmes d’IA utilisé au sein de l’UE appartient à cette catégorie, la Commission européenne recommande (sur la base du volontariat) que les fournisseurs soient conformes aux exigences pour donner confiance en leurs systèmes.

Figure 13 : Les actions à mener en fonction du risque associé à l’utilisation des systèmes d’IA (source : auteur) [5].

La définition des risques reste avant tout une volonté de la Commission Européenne à protéger ces citoyens. En effet, dans le cadre de la santé et du biomédical, il est impératif que chaque acteur des DM ainsi que les patients puissent connaître les exigences supplémentaires et les modifications que cette proposition de règlement entraîne dans la conception, l’exploitation, l’évaluation et la sécurité de l’IA.

Dans ce contexte, une aide à la compréhension de ce règlement semble pertinente [5].

La Commission européenne est consciente qu’il faut urgemment encadrer l'usage de l’IA qui ne cesse de se développer quel que soit le secteur auquel elle est appliquée.

De façon générale, la proposition de règlement sur l’IA vise l'identification de la classe de risque des dispositifs d’IA, à usage professionnel, pour pouvoir les encadrer par la suite. Le niveau de conformité aux exigences réglementaires demandé est le reflet du niveau de risque estimé : d'où la création d’une nouvelle classification des risques.

La préoccupation majeure provient des systèmes à risques inacceptables et élevés, raison pour laquelle ils sont fortement détaillés dans ce texte. La proposition s’attarde particulièrement sur l’utilisation des systèmes biométriques à distance en temps réel dans des espaces accessibles au public. Considérés comme des IA à risque élevé, elle mentionne que leurs utilisations sont strictement régulées et autorisées à titre d’exception.

A noter les domaines et champs d’activité ne sont pas traités de façon égale, certains (ex : systèmes d’IA développés / utilisés à visé uniquement militaires) sont même omis.

Peu d'éléments introduits dans ce texte réglementaire sont relatifs au secteur de la Santé :

- Une gouvernance institutionnelle désignée, facilite l’accès aux algorithmes, aux données de santé (entrainement), sans discrimination, tout en garantissant la sécurité et le respect de la vie privée des patients concernés (considérant 45) .

- Les enjeux du secteur font que les systèmes de diagnostic et d’assistance médicale doivent être fiables et précis (considérant 28).

D’où la difficulté de situer l’apport de ce texte dans ce domaine d’activité.

Par ailleurs, il n’est pas aisé de déterminer quelle classification assigner aux systèmes d’IA. En effet la liste (annexe III) qui désigne, par usage, les systèmes IA à haut risque, n’est pas assez exhaustive. Celle-ci, devant être revue prochainement, n’adresse en aucun cas l’usage des systèmes IA à des fins médicales. Il est donc difficile d’imaginer comment un fabricant prenant connaissance de ce texte pourrait déterminer la classe de son système.

Partie III : Les obligations européennes à respecter pour la sécurité du patient

1. Les exigences attendues pour chaque acteur

1.1 Exploitant, Mandataire, distributeur

Exigences mises en évidence par les différents textes de loi :

Outre la notion de risque, la Commission européenne distingue les obligations imposées selon le tiers qui la consulte dans le cadre des systèmes d’IA considérés à haut risque :

⇒ Fournisseurs : sont responsables de la mise en conformité de leurs systèmes vis-à-vis des exigences imposées par le règlement et de la mise en œuvre d’un système de gestion de la qualité. Ils doivent établir et mettre à jour la documentation technique pertinente et veiller au respect des obligations concernant l’évaluation de la conformité et l’enregistrement, de l’initiative de prendre des mesures correctives et de contacter / coopérer avec les autorités compétentes quand nécessaire.

Exigence générale (avant proposition)

- Réalisation d'essais de produits et contrôle du respect de toute condition imposée aux fournisseurs et en rapport avec les décisions de certification, telle que l'obligation de mettre périodiquement à jour les données cliniques. Cela sera évalué par les Organismes Notifiés périodiquement.

- Chaque cinq ans, les fournisseurs doivent démontrer leurs procédures de fabrication et autres processus pertinents par un audit sur place par l’Organisme Notifié. Cela afin de valider la conformité du produit.

- Au moins chaque douze mois, les fournisseurs doivent démontrer le bon fonctionnement du Système de Management de Qualité, vérifié avec un audit sur place par l’Organisme Notifié. De plus, il est nécessaire d’afficher l'application du plan de Surveillance Après Commercialisation.

⇒ Fabricants : également responsables de la conformité.

Exigence générale (avant proposition)

- Le Règlement 2017/45 précise que le fabricant doit :

- Attribuer à son DM un IUD-ID

- Enregistrer son DM sur la liste EUDAMED

- Est responsable des démarches pour obtenir le marquage CE (déclaration de conformité UE).

- S’assurer que son DM est conforme aux exigences qui le concerne et réaliser les actions correctives nécessaires si nécessaire.

- Mettre en place un système de gestion de la qualité permettant, grâce à des procédures, d’assurer un maintien de la conformité de la production

- S’assurer qu’une documentation technique et un système de gestion des risques existe et soit régulièrement tenue à jour.

- Planifier, réaliser et documenter l’évaluation clinique démontrant les propriétés de son DM.

- En cas de risques graves, il a pour responsabilité de prévenir les autorités compétentes.

⇒ Tous Tiers : (distributeurs, importateurs…) mettant un système d’IA sur le marché ou en service, modifiant sa destination ou y apportant une modification substantielle est soumis aux mêmes obligations que les fournisseurs.

« Distributeur », toute personne physique ou morale faisant partie de la chaîne d'approvisionnement, autre que le fabricant ou l'importateur, qui met un dispositif à disposition sur le marché, jusqu'au stade de sa mise en service.

« Importateur », toute personne physique ou morale établie dans l'Union qui met un dispositif provenant d'un pays tiers sur le marché de l'Union.

« Mandataire », toute personne physique ou morale établie dans l'Union ayant reçu et accepté un mandat écrit d'un fabricant, situé hors de l'Union, pour agir pour le compte du fabricant aux fins de l'accomplissement de tâches déterminées liées aux obligations incombant à ce dernier en vertu du présent règlement.

Exigence générale (avant proposition)

- Les tiers doivent vérifier que le dispositif porte le marquage CE, la déclaration de conformité UE et est étiqueté avec la notice d'utilisation requise (IUD).

- Dans le cas où, le dispositif présente un risque grave ou/et est falsifié, les tiers doivent informer l'autorité compétente de l'État membre dans lequel ils sont établis.

- Les tiers doivent vérifier que le dispositif est enregistré dans le système électronique et ajoutent les coordonnées.

- Les tiers doivent assurer les conditions de stockage ou de transport afin de ne pas compromettre la conformité.

- Les tiers doivent fournir un registre des réclamations, des dispositifs non conformes et des rappels et retraits aux fabricants.

- Les tiers doivent mettre en place les mesures correctives pour garantir la conformité de produit. Cela en coopération avec le fabricant.

- Les tiers doivent éliminer ou, si ce n'est pas possible, atténuer les risques présentés par des produits qu'ils ont mis sur le marché.

- Les tiers doivent disposer d'un système de gestion de la qualité prévoyant des procédures qui garantissent que la traduction des informations est fidèle et à jour

- Au cas où les tiers ont l'intention de mettre le dispositif ré-étiqueté ou reconditionné à disposition et le fournir, ils doivent faire une demande, au fabricant et à l'autorité compétente (28 jours avant).

Les tiers doivent atteindre un niveau approprié de traçabilité des dispositifs.

⇒ Utilisateurs : utilisation faite dans le respect des instructions d’utilisation, s’assurent que les données d’entrée sont pertinentes et qu’en période de fonctionnement, les « résultats » sont conformes à ceux prévus par le fabricant.

En contrepartie, le règlement doit garantir des conditions de concurrence équitable quel que soit la provenance des fournisseurs et leur système d’ IA.

Chaque acteur doit prendre en compte ces règles établies de manière harmonisée afin de participer à la construction d’une stratégie européenne qui se veut cohérente et gage de respect envers les libertés de droits fondamentaux. Il en va pour tous les domaines qui souhaitent utiliser et exploiter cette technologie.

Le rappel de ces “obligations” permet de recontextualiser les attentes pour chaque partie, dans le cadre d’un haut niveau de risque.

L’étude des anciens textes de loi, associée à cette proposition, permet de mettre en avant les exigences à respecter pour chacun.

En étudiant le règlement (UE) 2017/745 qui rappelle les obligations des acteurs de la vie d’un DM et le Code de la Santé Publique, il peut être constaté que les exigences indiquées dans la proposition sont un résumé de celles que ces deux textes ont détaillé [39], [48], [49].

1.2 Professionnel de la Santé (Médecin, Ingénieur Biomédical, Établissement de Santé)

L’accélération des progrès technologiques liés à l'IA, du Big Data et de la robotique se traduit par de nouvelles interrogations éthiques et exige de poser de nouveaux repères en matière d’usage.

Les questions de vie privée, de protection des données et de maîtrise des données personnelles prennent une nouvelle dimension, de même que les responsabilités associées à des décisions prises par des machines.

Exigences spécifiques aux acteurs exploitant des systèmes d’IA :

Médecin : Le médecin doit être formé à l’utilisation d’un Dispositif Médical basé sur l'Intelligence Artificielle. Il doit être vigilant au respect des droits du patient lorsqu’il envisage d’utiliser un dispositif d’IA. Il doit également expliquer clairement au patient qu'il a recours à une Intelligence Artificielle. Il est essentiel de conserver pour objectif le libre choix des individus en s’assurant des capacités de l’utilisateur à faire un choix.

Le médecin doit être capable de porter un regard critique sur les analyses, les résultats et les recommandations fournis par ces dispositifs pour éviter les risques liés à l’IA.

L’utilisation des données personnelles des patients doit être effectuée dans le respect du secret professionnel et du règlement général sur la protection des données.

Ingénieur biomédical : Une des missions de l’ingénieur biomédical est de proposer les bons équipements aux bons services. Lorsque ces derniers souhaitent certains types de dispositifs utilisant de l’IA, la vigilance est de mise, notamment sur les aspects de cybersécurité et fonctionnement du dispositif ][50], [51]. Il est donc essentiel de maîtriser les notions d’Intelligence Artificielle et de se tenir informé de manière continuelle sur l’aspect de sécurité des données et les performances de chaque dispositif souhaité. Une coordination est nécessaire avec le service informatique de l’hôpital pour gérer ces aspects.

L’AFIB (Association Française des Ingénieurs Biomédicaux) a présenté en décembre 2020 un webinaire sous forme de cinq recommandations pour la sécurité numérique des équipements biomédicaux [52] :

- Intégration de la sécurité numérique dans les procédures d’acquisition : pour cela, l’AFIB propose un question de 160 questions relatives aux conformités de réglementation à destinée des fournisseurs ;

- Définition de la collaboration dans les établissements de santé : des points de vigilance mis en avant par l’AFIB sont proposés afin de créer une collaboration entre la Direction des Systèmes d’Information (DSI) pour les achats, les installations et la maintenance ;

- Assurance de la sécurité des équipements biomédicaux : vérification du respect du marquage CE ou encore de la gestion de la sécurité des connexion pour la bonne maîtrise des dispositifs ;

- Définition de la criticité des équipements biomédicaux : proposition de l’AFIB sous forme d’une notation de vulnérabilité informatique en 10 points, traitant de la question sur le code d’accès sécurité à la réalisation de tests d’intrusion.

- Action rapide en cas de cyberattaque : en se basant sur l’Agence Nationale de la Sécurité des Systèmes d’Information (ANSSI), des avis ont été émis comme ne pas débrancher le réseau ou encore s’assurer de bien signaler les incidents. L’AFIB recommande en aval de ces avis des formations en interne.

Établissements de santé : Les établissements de santé doivent sécuriser leurs réseaux informatiques pour faire face aux cyberattaques. Chaque établissement de santé doit désigner un correspondant local de matériovigilance.

Les exigences par acteur

- Médecin

- Code de déontologie médicale : Relation médecin-patient avec

- Article 2 : Respect de la vie et de la dignité de la personne.

- Article 4 : Secret professionnel

- Serment d’Hippocrate : Respect de la vie humaine.

- Code de la santé publique : Article L1110-4 ⇒ Respect de la vie privée et du secret des informations.

- Code de la santé publique : Article L4001-3 ⇒ Le professionnel de santé qui décide d'utiliser, pour un acte de prévention, de diagnostic ou de soin, un dispositif médical comportant un traitement de données algorithmique dont l'apprentissage a été réalisé à partir de données massives s'assure que la personne concernée en a été informée et qu'elle est, le cas échéant, avertie de l'interprétation qui en résulte.

- Ingénieur biomédical

- Cybersécurité - Service Informatique

- Lien avec les fournisseurs de DM utilisant l’IA

- Audit pour la surveillance du parc biomédical

- Connaissance des risques et vulnérabilités

- Établissement de santé

- Règlement Général sur la Protection des Données (RGPD)

- Code de la Santé publique : R.5212-12 (Matériovigilance)

- Agence nationale de la sécurité des systèmes d'information

Figure 14 : Obligations à respecter par les professionnels de la santé (Source : auteur)

1.3 Investigation : Retour Terrain

Pour avoir un retour reflétant la situation sur le terrain, deux types d’investigation ont été réalisées.

L’une, à destination des fabricants, s’est déroulée sous forme d’interview réalisée auprès de deux entreprises ayant répondu positivement aux sollicitations par mails du groupe. Les questions posées ont été adaptées en fonction des réponses délivrées par les interviewés. L’objectif était de déterminer, dans un premier temps, les exigences que respectent les fabricants pour leurs DM et dans un second temps, d’évaluer leur niveau de connaissances sur la nouvelle proposition et leurs avis sur celle-ci, notamment sur l’impact que sa mise en application aurait potentiellement sur leurs activités.

La seconde, à destination des exploitants, a permis, au moyen d’un questionnaire, distribué à une sélection de participants, d’évaluer leurs niveau de connaissances, leurs intérêts, ressentis et attentes envers les systèmes d’IA, notamment en termes de niveau de sécurité et de confiance.

Il a ainsi été possible de se renseigner sur le regard que porte actuellement le personnel soignant sur ces technologies d’IA en pleine émergence.

Point de vue des Fabricants :

Entreprise : A

Dispositif : Logiciel d’analyse de radiographies traumatiques

⇒ Classe IIa ; utilisation à court terme

Réglementations

France :

- RDM 2017/745 ;

- Norme 13485 (SMQ) ;

- Norme 27001 (cybersécurité) ;

- RGPD ;

- DPA = déclaration sous traitant ;

- Notions de bioéthique (Loi);

Etats-Unis :

- Privacy by design ;

- Conformité IPA ;

- FDA.

Connaissance de la proposition

- Aucune connaissance sur la nouvelle proposition.

- Information synthétisée apportée par le groupe de projet.

Avis sur la proposition

- Questionnement sur l'intérêt de la proposition.

- Avis mitigés sur l’apport amené par la proposition dans le cadre des activités du dispositif.

- La probabilité que la société et le DM soient impactés par cette proposition semble faible : proposition très générique, la Santé est à peine citée.

Entreprise : B

Dispositif : Plateforme de co-création & distribution d’algorithme médical dans le secteur de l'imagerie

⇒ Classe IIa

Réglementations

France :

- RDM 2017/745 ;

- RGPD ;

- ISO 14971 (gestion des risque) ;

- ISO 13485 (SMQ) ;

- EN 62304 ;

Réglementation notamment aussi en Suisse (Pour Keros).

Connaissance de la proposition

Prise de connaissance de la nouvelle proposition : → Chargé d’affaires à lu le texte et participer à un événement d’information dessus

→ Participera prochainement à un groupe de travail organisé par le SNITEM.

Avis sur la proposition

Nécessité d’apporter de la clarification sur la définition de DM à haut risque → pour pouvoir évaluer les DM concernés par cette nouvelle classification des risques.

Chargé d’affaires réglementaire estime que le logiciel devrait être considéré comme un système à haut risque → divergence de niveau en fonction du règlement 2017/745 et proposition de loi = est-ce que les niveaux/classes de risques vont s’accorder ? Si oui, établir une adaptation des modalités d’évaluation des DM ?

Questionnement sur la pertinence :

→ Majorité des éléments cités dans la proposition retrouvée dans le règlement (= >90% exigé l’entreprise le fait déjà)

→ Réglementation pour le secteur médical déjà très robuste. Proposition n’apporte pas de nouvel élément (exigences, informations…) [51]

→ Mise en place d’un système parallèle d'appel vigilance spécifique aux logiciels = redondance (procédure de déclaration à l’ANSM amplement satisfaisant)

Inquiétude :

Validation double audit par ON différents (un pour la réglementation et un spécifique au logiciel IA ) (nouveaux ON accrédités)

Impact sur les activités de l’entreprise : proposition vue comme une perte de temps et d’argent.

Analyse :

A travers ces retours, une visualisation du situation terrain professionnel et des échanges pertinents ont pu être établis. L’IA à toute sa place dans le secteur de la Santé Français, ces interviews ont été déterminantes pour comprendre les enjeux et l’évolution de ces technologies au sein du territoire.

Il est rappelé que la proposition ne mentionne aucunement comment classer les systèmes d’IA du secteur médical. Dans la mesure où la classification du Règlement 2017/745, introduisant les exigences à respecter en fonction du niveau de dangerosité du dispositif, classe les logiciel d’IA (aide/assistance au diagnostic) comme dispositif de classe II à III, il est fort probable que les logiciels de diagnostic soit classé comme dispositif médical de risque modéré à élevé.

Hors l’absence du domaine médical dans l’annexe III impliquerait qu’il soit tous considérés comme dispositif à risque modéré : pas pertinent aux vues des exigences demandées par les autorités.

Le respect d’un nombre élevé d'exigences est demandé aux fabricants pour pouvoir libérer leur produit sur le marché. Garantir la sécurité d’usage et la performance pour le bien des patients est une obligation majeure que respectent déjà les industriels.

Cette proposition apporte au final quelques inconvénients :

- Les exigences émises par la proposition en termes de classification des risques devraient s’accorder à celles dictées dans les règlements 2017/745 et 2017/746 pour faciliter sa compréhension et sa transposition aux autres textes réglementaires.

- La mise en place d’audit dédié aux logiciels d’IA à haut risque : double audit (ON spécialisé IA à haut risque ?) ou ON dédiés aux logiciels d’IA évaluant tous les aspects réglementaires exigé quel que soit le niveau de risque.

Un point intéressant, qui sera par la suite développé à travers un outil interactif, reste néanmoins que la proposition permet d’apporter de la cohérence en synthétisant les obligations que chaque acteur doit respecter et qu’avec une nouvelle classification des risques cette proposition cherche à mieux encadrer les systèmes d’IA, en particulier ceux à haut risque, dont le danger est plus élevé.

Ces éléments démontrent l'intérêt grandissant que porte l’Union Européenne, qui a conscience que la technologie de l’IA se développe rapidement : projet de création du comité européen de l’Intelligence Artificielle (CEIA) chargé de “stimuler l’élaboration des normes sur l’IA”.

Les actions qu’elle effectue pour créer un environnement propice à son développement (libre circulation corrélé à la sécurité d’usage et la protection des données notamment) vise à la rendre leader mondiale. Elle n’hésite pour cela pas à accompagner les fabricants et à soutenir les systèmes innovants conformes aux valeurs et aux principes revendiqués par l’union européenne (“Bac à sable réglementaire, accompagnement de la CNIL…) [54].

2. Développement d’un outil facilitant le respects des exigences imposées aux différents acteurs

Au fil de ce projet, il est apparu nécessaire d’établir un outil PDF interactif ayant pour objectif d’expliciter le lien entre la proposition de réglementation européenne sur l’IA et le secteur de la santé.

En plus d’introduire les apports amenés par celle-ci, en explicitant notamment son contenu, le document interactif se veut simple d’utilisation et informatif de façon à ce qu’un lecteur néophyte puisse comprendre instinctivement les notions de base à ce sujet.

Ce document interactif, à l’instar des autres livrables de ce projet, est disponible sur la plateforme “Travaux Master UTC”, accessible via le lien DOI indiqué en bas de page.

Conclusion

La multitude de domaines auxquels l’IA peut être appliquée et son contexte évolutif ont donné lieu à une réflexion de l’Union Européenne sur sa réglementation : formulation d’une proposition de règlement européen sur l’IA visant à la fois à son développement et à la protection des citoyens.