IDS122- Intelligence Artificielle et Imagerie Médicale

Les projets ou stages publiés auxquels vous accédez sont des rapports d'étudiants et doivent être pris comme tels. Il peuvent donc comporter des imperfections ou des imprécisions que tout lecteur doit admettre et donc supporter. Il ont été réalisés pendant les périodes de formation et constituent avant-tout des travaux de compilation bibliographique, d'initiation et d'analyse sur des thématiques associées aux concepts, méthodes, outils et expériences sur les démarches qualité dans les organisations ou sur les technologies en santé.

Si, malgré nos précautions, vous avez des raisons de contester ce droit de diffusion libre, merci de nous en faire part (master@utc.fr), nous nous efforcerons d'y apporter une réponse rapide. L'objectif de la présentation des travaux sur le web est de permettre l'accès à l'information et d'augmenter ainsi la qualité des échanges professionnels.

Nous ne faisons aucun usage commercial des travaux de projet ou de stage publiés, par conséquent les citations des informations et l'emploi des outils mis à disposition sont totalement libres. Dans ce cas, nous vous demandons de respecter les règles d'éthique en citant explicitement et complètement vos sources bibliographiques.

Bonne lecture...

Auteurs

Contacts

- Haissam HAIDAR AHMAD : haissamhaidar97@hotmail.com

- Mohammed Alamin HAMID SALIH : alhameem733@gmail.com

- Alison LUANGRATH : luangrath.alison@gmail.com

- Théo SEDE : theosede38@gmail.com

- Lucas ZUGAJ : lucaszugaj@outlook.fr

Citation

A rappeler pour tout usage : H. HAIDAR-AHMAD, M. A. HAMID SALIH, A. LUANGRATH, T. SEDE. L. ZUGAJ, "Intelligence Artificielle et Imagerie Médicale", Université de Technologie de Compiègne (France), Master Ingénierie de la Santé parcours Technologies Biomédicales et Territoires de Santé, Mémoire de Projet, https://travaux.master.utc.fr/, réf n° IDS122, https://doi.org/10.34746/kbkc-cd39, janvier 2022, https://travaux.master.utc.fr/formations-master/ingenierie-de-la-sante/ids122/

Remerciements

L’ensemble de notre groupe tient particulièrement à remercier tous les contributeurs de ce travail.

Nous remercions l’Université de Technologie de Compiègne et l’ensemble de l’équipe pédagogique du Master Ingénierie de la Santé pour l’opportunité de participer à ce projet publié pour la communauté biomédicale. Merci à Isabelle CLAUDE, Jean-Matthieu PROT et Gilbert FARGES pour tous leurs précieux conseils durant ces deux années d’études et tout au long du projet.

Nous adressons également notre gratitude à l’ensemble des intervenant et professionnels de santé qui ont accepté de nous accorder de leur temps pour répondre à nos questions et nous aiguiller sur des pistes de réflexion. Nous avons développé des connaissances solides dans le domaine de l’Intelligence Artificielle en imagerie médicale grâce à vous.

Enfin, nous tenons à remercier tous nos camarades de promotion pour leur aide et leurs retours sur nos travaux qui nous ont permis d’améliorer en continu notre travail tout au long des jalons.

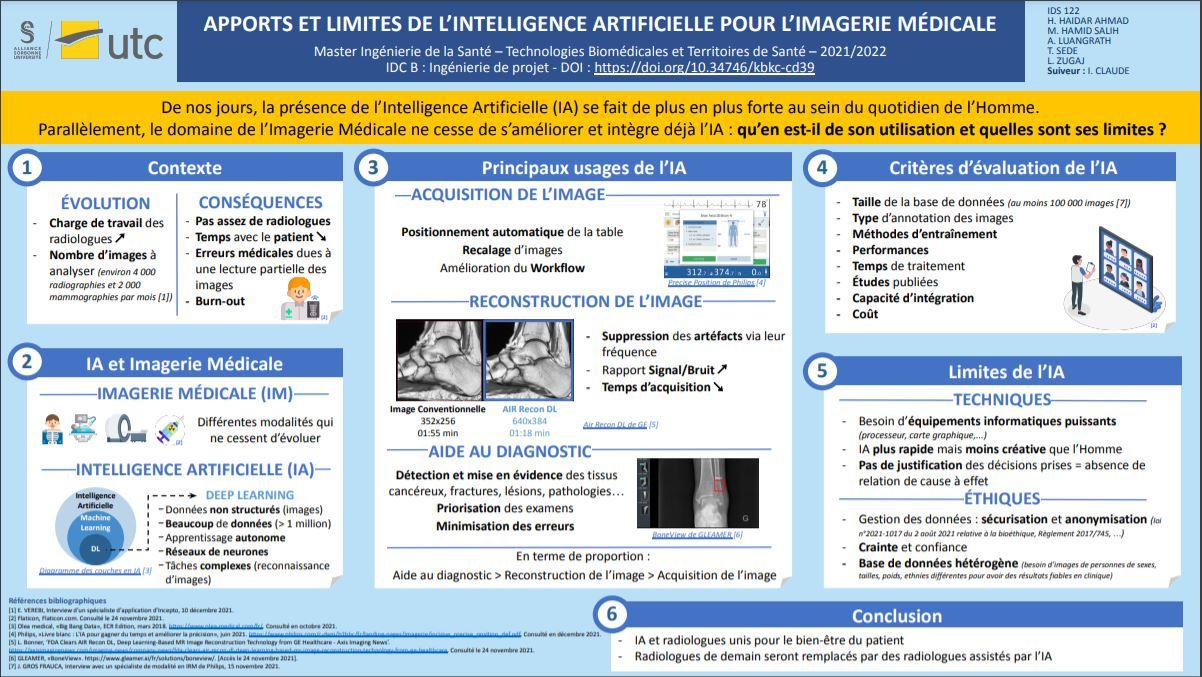

Résumé

L'Intelligence Artificielle (IA) se développe de plus en plus dans le domaine de la radiologie pour diverses applications et prend une place significative dans la routine de travail des radiologues. En effet, l’explosion des données médicales a entrainé un bouleversement de la charge de travail des radiologues, limitant le temps passé avec le patient et augmentant le taux d’erreur d’interprétation. Les logiciels d’IA proposent, dans le domaine de l’Imagerie Médicale, une aide au diagnostic en mettant en évidence les éléments jugés pathologiques ou en priorisant les examens pour les radiologues par exemple. Aujourd’hui, en plus de cela, l’IA permet d’améliorer la qualité des images radiologiques et la précision de leur acquisition. Cependant, ces logiciels, pouvant représenter de réels outils diagnostic pour le radiologues, sont très divers et présentent des limites éthiques et techniques. Comprendre le fonctionnement et faire le tri parmi ces solutions pour les radiologues peut s’avérer difficile. Ce projet tente d’apporter des éléments pour mieux comprendre les solutions proposées par les développeurs d'IA, et définir les principaux critères d’évaluation dans le but de guider les radiologues dans leur choix.

Abstract

The artificial Intelligence (AI) development increases for several purposes in radiology and takes a significant place in radiologists working routine. Indeed, the expansion of medical data has led to an increase of the radiologists' workload, limiting the time spent by the radiologists with the patients and raising the interpretation error rate. The AI software in the medical imaging field assists the radiologist in the diagnostics by pointing out the pathological elements or by prioritizing the urgent exams. In addition, nowadays, AI allows improving the quality of radiologic images and the precision of its acquisition. Nevertheless, this kind of software could be a real tool for helping radiologists to diagnose the abnormality, there are many kinds of software, and it is confined by ethical and technical limits. Understanding the functions of these software programs, and being able to choose between them, can be difficult for radiologists. This project aims to allow understanding of all these software programs and to define the main requirement for the evaluation to guide the radiologists in their choices.

Liste des abréviations

IA : Intelligence Artificielle

IM : Imagerie Médicale

DM : Dispositif Médical

S/B : Signal/Bruit

Téléchargements

Mémoire Complet :

« Apports et limites de l’Intelligence Artificielle pour l’Imagerie Médicale »

Introduction

Aujourd'hui, la présence de l’Intelligence Artificielle (IA) se fait de plus en plus forte au sein du quotidien de l’Homme : dans la navigation avec les GPS, les emails, mais aussi avec les assistants vocaux intégrés dans les smartphones par exemple. Le domaine de la santé doit également suivre les avancées technologiques afin d’évoluer. Dans les services d’Imagerie Médicale (IM), l’IA est d’ores et déjà existante mais est-elle vraiment bien implantée et quelles sont ses limites ? Afin de mieux cerner le sujet, il s’agit en premier lieu de bien définir les termes impliqués.

L’IA définie comme « l’ensemble de théories et de techniques mises en œuvre en vue de réaliser des machines capables de simuler l'intelligence humaine » [1] est en plein essor. Depuis les années 1950, elle ne cesse d’évoluer afin de peut-être atteindre un jour la parfaite alliance entre l’Homme et la machine. L’IM est, quant à elle, considérée comme une « spécialité médicale consistant à produire des images du corps humain vivant et à les interpréter à des fins diagnostiques, thérapeutiques (imagerie interventionnelle) ou de surveillance de l’évolution des pathologies » [2]. Tout le monde, au cours de sa vie, peut être amené à réaliser un examen d’IM. Il existe différentes modalités, chacune avec des caractéristiques spécifiques.

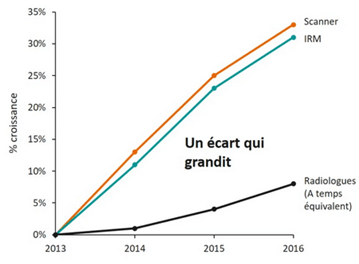

Dans notre cas, de nombreux enjeux sont donc à prendre en compte lors de l’utilisation de l’IA dans l’IM. Tout d’abord d’un point de vue médical, afin de pouvoir améliorer le diagnostic et les traitements associés, ainsi que leur précision. Une question de renommée est également en jeu : une technologie de pointe peut renforcer la reconnaissance d’un établissement. Il y a aussi des enjeux économiques importants qui sont à considérer car l’intégration d’une IA demande à évaluer divers paramètres. L'IA peut être un gain de temps pour le personnel soignant, déléguant certaines tâches à l’IA, mais cela pourrait également impliquer la modification de l’organisation et des compétences requises dans certaines spécialités médicales. En 2015, un radiologue interprétait en moyenne une image CT ou IRM toutes les 3 à 4 secondes au cours d’une journée de travail de 8 heures. En effet, le nombre d’examens d’imagerie a explosé ces dernières années sans pour autant qu’il y ait une augmentation proportionnelle du nombre de radiologues (voir Figure n°1). Cela implique un nombre de clichés à interpréter par radiologue considérablement plus important, un temps de traitement par examen plus court et donc potentiellement un taux d‘erreur d‘interprétation plus grand [3].

Figure n°1 : Graphique de l’évolution du nombre d’actes (Scanner/IRM) et du nombre de radiologues entre 2013 et 2016 (source : siemens-healthineers.com)

Aujourd’hui, l’IA pourrait représenter une aide considérable aux radiologues impliquant donc une adaptation de leur méthode de travail et de diagnostic.

Ces points mènent finalement à se demander quelle est l’offre en IA pour l’IM en France et quelle évaluation en est proposée afin de faciliter le choix des radiologues. Pour répondre à cette problématique, il faudra dans un premier temps définir ce que sont l’IM et l’IA plus précisément ainsi que les acteurs concernés. Puis, une analyse de l’association de ces deux domaines sera faite, avec les enjeux et risques que cela implique. Enfin, un benchmark des différentes solutions existantes et leurs évaluations sera proposé avant de conclure.

I - Définition, historique et acteurs de l’Imagerie Médicale et de l’Intelligence Artificielle

Les définitions des termes « Imagerie Médicale » et « Intelligence Artificielle » ont déjà été données précédemment, mais afin de mieux les comprendre, il est nécessaire d’approfondir le sujet et de comprendre leurs origines.

A) Imagerie Médicale

- Evolution de l'IM

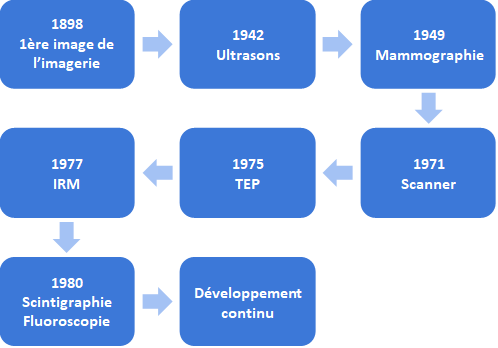

Après la découverte des rayons X à la fin du XIXe siècle, l’IM de diagnostic a rapidement évoluée. Différentes modalités ont vu le jour, et à partir des années 70, l’IM en 3D est née avec l’apparition du scanner, de la Tomographie par Émission de Positons (TEP) et de l’Imagerie par Résonance Magnétique (IRM) (voir Figure n°2). De nos jours, l’IM ne cesse de s’améliorer afin de proposer au patient l’examen le plus rapide et complet possible comme les images en 4D et le Real Time Imaging.

Figure n°2 : Evolution de l’IM (source : auteurs)

L’IM est principalement utilisée dans le domaine du diagnostic médical, mais elle peut aussi être utilisée dans le domaine thérapeutique.

- Applications de l’IM dans le domaine thérapeutique

L'IM, qui était spécialisée dans le diagnostic des fractures des os à ses débuts, a par la suite été développée dans des directions plus différentes, notamment le domaine thérapeutique qui regroupe deux domaines d’utilisation importants de l’IM.

La première est la procédure guidée par imagerie :il s’agit d’une représentation dont le but est de diriger les processus thérapeutiques et minimiser leurs dommages. Dans ce cas, il y a par exemple « la biopsie pulmonaire guidée par TDM qui est une méthode efficace, complémentaire de la bronchoscopie souple, pour le diagnostic du cancer broncho-pulmonaire » [4]. L'imagerie avec la méthode susmentionnée vise à diagnostiquer une tumeur, à surveiller les changements de traitements au fur et à mesure qu'ils surviennent et à surveiller l'échec ou le succès du traitement.

L’autre domaine d’application très connu est l’imagerie fonctionnelle où « selon la nature des recherches, on distingue celles qui fournissent des propriétés structurelles de la zone étudiée (IRM, Rayons X, ...), de celles qui restituent des aspects fonctionnels (TEP, IRM Fonctionnelle...) » [3]. L’un des cas possibles grâce à l’IM est la surveillance de l'activité cérébrale ainsi que le moment de sa réaction aux stimuli moteurs, émotionnels et mentaux. En effet, l'activité de différents centres cérébraux est caractérisée par une consommation accrue d'oxygène et, à l'aide de l'IRM, les changements causés par l'augmentation de la consommation peuvent être observés, avec le moment de leur apparition.

L’IM a donc beaucoup évolué en très peu de temps. Souvent essentielle lors de l’élaboration d’un diagnostic, elle se démarque par sa polyvalence et la vaste étendue de ses champs d’application.

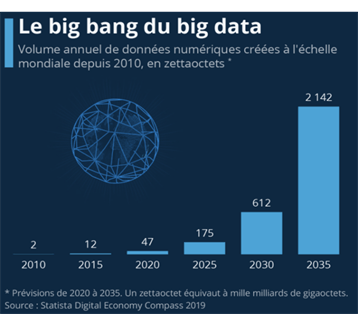

- Le Big Data en Imagerie Médicale

Les avancées technologiques ont permis aujourd’hui d’aller de l’avant dans de nombreux domaines dont celui de la santé, permettant ainsi d’améliorer le diagnostic et le traitement des patients. Ces avancées technologiques ont été aLes avancées technologiques ont permis aujourd’hui d’aller de l’avant dans de nombreux domaines dont celui de la santé, permettant ainsi d’améliorer le diagnostic et le traitement des patients. Ces avancées technologiques ont été accompagnées d’une explosion du volume de données créées, multipliées par 25 en l’espace de 10 ans (voir Figure n°3) [5]. Cet afflux de données représente aujourd’hui un enjeu majeur pour le secteur de la santé. En effet, les données provenant des résultats et analyses médicales des patients pourraient aider à la personnalisation des traitements, au développement de systèmes d’aide au diagnostic mais aussi à la prise de décision clinique et à l’identification des facteurs de risques et des menaces sanitaires [6], [7].

Figure n°3 : L’évolution du volume de données numériques depuis 2010 (source : Idc seagate, Statista)

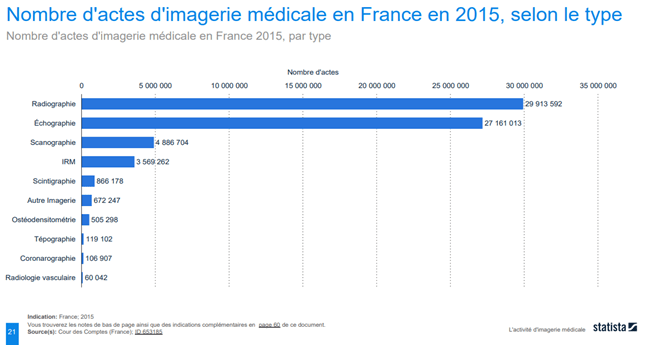

En France, le nombre d’actes d’IM a beaucoup augmenté au fil des dernières années. Il y a eu une augmentation de l’utilisation de l’IM en diagnostic et une croissance de la quantité de données avec plus de 60 millions d’actes en 2015 [4] (voir Figure n°4). Selon l’étude de la Cour des Comptes de 2015, les techniques de radiographie et d'échographie sont beaucoup plus utilisées que les autres techniques grâce à la facilité de leur mise en place et leur rapidité.

Figure n°4 : Diagramme du nombre d’actes d’IM en France en 2015, selon le type d’imagerie (source : Cour des Comptes, publié en mai 2016)

Les appareils biomédicaux d’aujourd’hui sont plus performants et viennent à produire jusqu’à 1000 à 1500 images par examen, soit plus de 40 fois plus qu’il y a 30 ans. L’IM représente donc une part importante des activités médicales en France, avec une quantité de données augmentant parallèlement au nombre d’actes. Il paraît évident que ces données deviennent impossibles à analyser par un seul être humain et nécessitent l’aide de machines. Aux Etats- Unis, 34% des radiologues disent utiliser l’IA dans leurs pratiques cliniques [8] puisqu’elle propose des méthodes de calculs élaborées et des algorithmes innovants tels que le Deep Learning, trouvant leur place dans des secteurs comme l’IM [5].

B) Intelligence Artificielle

L’IA est de plus en plus présente au quotidien, elle existe dans nos systèmes informatiques, en navigation, etc. L’IA est de plus en plus présente au quotidien, elle existe dans nos systèmes informatiques, en navigation, etc. Cependant, définir l’IA n’est pas si simple car pour cela il faudrait déjà réussir à le faire pour l’intelligence : « Tout problème pour lequel aucune solution algorithmique n’est connue, relève à priori de l’IA » et de son système d’apprentissage [6]. L’IA est un ensemble d’algorithmes qui va permettre l’élaboration de solutions pour une problématique donnée [9].

- Naissance et développement

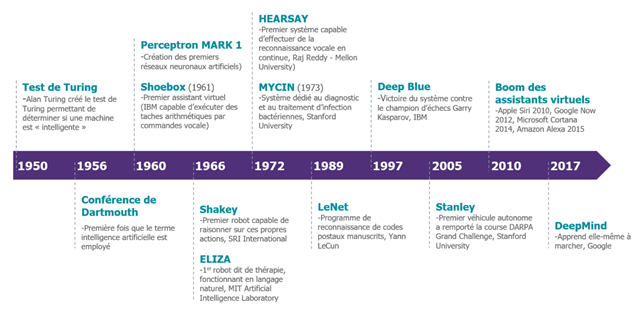

Comme le montre la Figure n°5, l’IA est apparue avec Alan Turing avec son idée qu’une machine puisse penser. Warren Weaver émet une idée similaire, il pensait que des tâches liées à l’intelligence humaine pouvaient être exécutées par des machines. L’utilisation de l’IA ne fait que progresser, notamment en IM.

Figure n°5 : Frise chronologique de l'IA (source : digitalcorner-wavestone.com)

En 1957, le plus ancien algorithme d’IA a été conçu pour la reconnaissance de patterns. Cependant, ce n’est que vers les années 2010 que le plein potentiel de ces réseaux a commencé à être exploité grâce au Big Data et aux traitement massivement parallèles [10].

L’IA est liée aux importantes avancées technologiques de ces dernières années. Les performances des ordinateurs se sont considérablement améliorées (loi de Moore), ce qui a permis de développer de nouvelles techniques [7]. Dans cette étude, seule l’IA dans le domaine de la santé et dans l’IM sera prise en compte, mais en réalité l’IA concerne de nombreux autres domaines comme l’industrie ou l’agriculture par exemple. Elle permettrait donc d’orienter le travail de certains métiers : dans le cadre de l'imagerie, elle pourrait aider à l’amélioration des images et au diagnostic [11].

L’IA a un aspect fondamental qui repose sur l’apprentissage, permettant d’améliorer les performances [12]. L’apprentissage est plus qu’essentiel pour l’IA car c’est ce qui va permettre au système d'évoluer avec les données. C’est-à-dire qu’avec l'arrivée de requêtes et nouvelles données (par exemple dire si une fracture est présente sur une image), l’IA devra réussir à fournir un résultat fiable. Si ce dernier n’est pas conforme à celui attendu, il faut pouvoir le notifier pour que l’IA apprenne de ses erreurs. Ainsi à la prochaine requête d’une problématique similaire, elle sera plus performante. L’IA peut être considérée comme la rencontre entre trois disciplines : les mathématiques, l’informatique et les sciences cognitives. Bien que ce concept ait un aspect futuriste, ces systèmes sont développés depuis des dizaines d’années. Il existe déjà plusieurs méthodes comme l’IA par réseaux de neurones, d’apprentissage par renforcement, etc [13].

- IA dans le domaine de la santé

L’IA représente un espoir dans le domaine de la santé : elle pourrait permettre d’améliorer la prise en charge des patients eL’IA représente un espoir dans le domaine de la santé : elle pourrait permettre d’améliorer la prise en charge des patients et de réduire la charge de travail des médecins sans affecter la qualité des diagnostics. La multiplication des données de santé donne de l’espoir quant aux applications de l’IA en santé : le dépistage précoce de cancer est un exemple d’application. Enfin, l’humain ne sera jamais fiable à 100% et exempt d’erreur, c’est pourquoi le développement d’outils d’aide permettrait de réduire les erreurs de diagnostic et d’éviter de passer à côté d’un potentiel indice en utilisant le Big Data qui est une très grande quantité de données - dans ce cas, il s’agit de données médicales. Pour pouvoir réaliser des calculs avec une grande masse de données, l’IA peut utiliser le Deep Learning (apprentissage profond) ou le Machine Learning (apprentissage automatique).

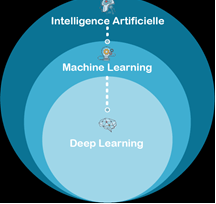

- Machine Learning

Le Machine Learning est l’un des sous-ensembles de l’IA qui est lui-même composé du Deep Learning (voir Figure n°6). Le Machine Learning se base sur l'expérience des machines qui peuvent l'utiliser pour améliorer leurs performances et l'exécution des tâches. L’apprentissage automatique permet l’ajout d’informations supplémentaires dans le modèle - comme le clustering (organisation des données de façon homogène) - et leur utilisation dans le cadre des entraînements. Il y a aussi évidemment une phase de test du modèle, ce dernier peut-être aussi utilisé pour des tâches de prédiction. Le Machine Learning permet à des machines d’effectuer des apprentissages automatiques même si elles n’ont pas été conçues et programmées pour cela au départ.

Figure n°6 : Diagramme des différents types d’IA (source : auteurs)

- Deep Learning

Dans cette partie sera décrit les principes théoriques du Deep Learning et des réseaux de neurones.

Le Deep Learning fait donc partie du Machine Learning et se base sur des réseaux de neurones artificiels. Comme pour le cerveau humain, ils sont composés de plusieurs couches. Il y a donc des données d’entrée et de sortie et ces neurones artificiels vont transformer les données qui entrent au fur et à mesure de la traversée des différentes couches. L’avantage de cette méthode est de pouvoir apprendre avec les données traitées à travers le système. Les systèmes de Deep Learning nécessitent des quantités importantes de données pour ses entraînements, la puissance de l'algorithme en dépend fortement. Il est donc nécessaire de disposer de machines suffisamment performantes pour réaliser ce traitement [14]. Dans le cadre de l'imagerie, cela peut s’appliquer dans la recherche de tumeurs par exemple. L’IA pourrait détecter d'éventuelles tumeurs en se basant sur une quantité de clichés importants, auxquels serait associée la présence de tumeur ou non. En plus de ses expériences fondées sur la réussite ou l’échec de cette détection, le programme peut améliorer son pouvoir de reconnaissance et sera plus fin dans ses analyses.

Dans le Deep Learning, un but à accomplir est donné à l’IA. Tous les cas de figures d’une problématique donnée ne sont pas programmés car il y a une très grande quantité de cas pouvant aller jusqu’à plusieurs millions : de ce fait, elle apprendra d’elle-même à y répondre. De ce fait, le système informatique crée ses propres algorithmes, ce qui met en évidence des capacités d’apprentissage de la machine. Durant cet apprentissage, des taux de réussite sont définis. Ils correspondent au pourcentage de bonnes réponses données par le système pour une problématique. Pour des images radiologiques, sont comparés les résultats réels (diagnostic de radiologues) et ceux fournis par l’IA, et cela se fait sur des milliers d'images [14]. Il est dit que l'entraînement est stabilisé si le pourcentage de réussite est jugé correct par les évaluateurs de la solution d’IA.

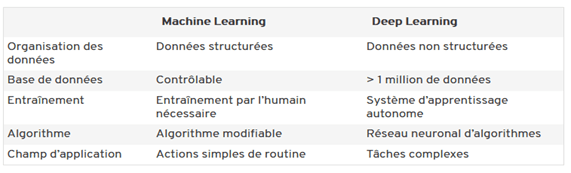

Pour résumer, un tableau comparatif présente ci-dessous les différences entre le Machine Learning et le Deep Learning, la principale résidant dans le fait que le Deep Learning travaille sur des données non structurées comme une image et utilise des réseaux de neurones convolutifs (voir Figure n°7).

Figure n°7 : Différences entre Machine Learning et Deep Learning (source : ionos.fr)

Malgré son grand potentiel, un des inconvénients du Deep Learning est la difficulté à expliquer les résultats obtenus. Cela est dû à l'utilisation des réseaux de neurones qui peuvent être complexes.

- Réseaux de neurones

Le terme de réseau de neurones artificiels a été créé en 1943 mais ce n’est que vers les années 2010 que le plein potentiel de ces réseaux a commencé à être exploité grâce au Big Data et aux traitements massivement parallèles [5].

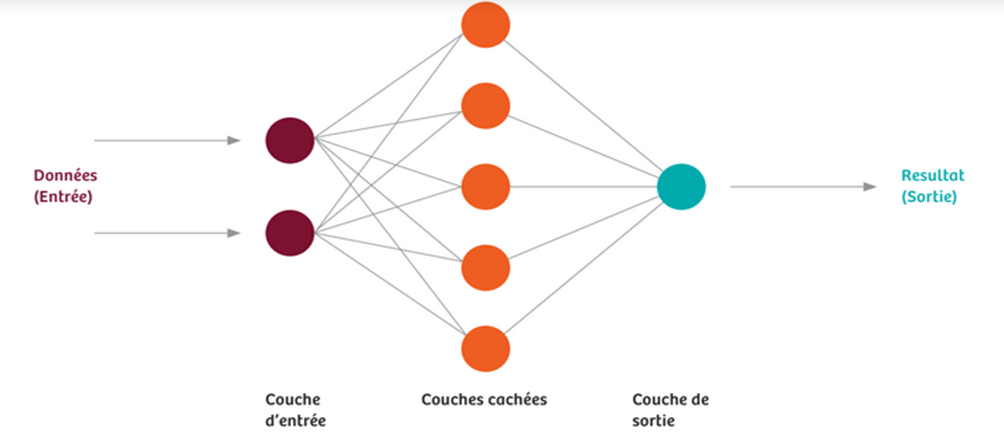

Les réseaux de neurones artificiels permettent le Deep Learning. Les bases de données (images médicales) vont alimenter ces réseaux et constituer des données d’entrées. Les neurones d’entrée vont ensuite transmettre ces données aux couches intermédiaires (couches cachées), puis à celles de sortie. Si un résultat différent de la réalité est obtenu, alors il y a une adaptation automatique du réseau qui est obtenu mathématiquement. Ces réseaux fonctionnent grâce à des algorithmes et des fonctions mathématiques qui sont dites d'activation : elles prennent une valeur d’entrée et la renvoie à un résultat. Dans le développement d’IA, il est difficile de déterminer les meilleures configurations, qui comprennent principalement le nombre de couches cachées, pour avoir un apprentissage plus efficace.Ce dernier va donc être constitué de répétitions de ces processus : il est considéré comme faisant effet lorsque le réseau interprète avec fiabilité de nouvelles données qui sont ici des images. L'expérience est donc la clé de l’apprentissage autonome [3].

Afin de mieux visualiser le fonctionnement des réseaux de neurones, une modélisation est présentée ci-dessous (voir Figure n°8).

Figure n°8 : Schéma simplifié d’un réseau de neurones (source : Siemens.com)

La création d’un réseau important est obtenue car un neurone est relié à d’autres d’une couche cachée, avec des informations qui se recoupent. Il peut y avoir plus d’une centaine de couches cachées avec des milliers de neurones dont la quantité est variable. Des situations complexes peuvent donc être modélisées avec des milliers de connexions. Pour utiliser des réseaux développés, il faut des modèles mathématiques avancés combinés à une grande puissance de calcul. C’est pour cette raison que la composante hardware des équipements d’imageries doit être performante. Il y a souvent beaucoup de processeurs utilisés parallèlement pour faire fonctionner ce type de système.

Les réseaux de neurones convolutifs sont utilisés pour reconnaître les images en les recevant sous la forme d’une matrice et à laquelle sont appliquées deux opérations : du filtrage pour détecter des formes et contours, et des simplifications pour en extraire les informations importantes. Il est dit que cette approche est inspirée du fonctionnement de l'œil et du traitement des informations visuelles [15]. En effet, certains neurones du cortex visuel vont réagir seulement aux bordures verticales, et d’autres horizontales. La convolution est à l’origine un outil en mathématiques [16] : le produit de convolution de deux fonctions revient à réaliser la moyenne pondérée de ces deux fonctions [17]. Les données brutes sont reçues par la première couche, c’est une analogie de la rétine de l'œil. Les récepteurs visuels reçoivent les rayons lumineux comme des données brutes qui seront analysées dans les couches neuronales plus profondes du cerveau. C’est pour cela que cette technique est très intéressante pour l’IM. Lors d’une série d'instructions, chaque neurone a un poids, aussi appelé connexion ou niveau d'activation, représentant des valeurs qui servent à propager les informations et servant d’intermédiaire pour convertir les données d’entrées en données de sorties. Ils ne sont pas définis et sont ajustés pour diminuer l’écart, nommé coût, entre la valeur obtenue et celle attendue (fixée par les développeurs ou le programmeur de l’apprentissage) qui donne une indication sur les poids à modifier. Ces derniers reflètent l’importance du neurone dans le traitement des données pour un cas. Comme pour le cerveau humain, les neurones du réseau peuvent être actifs ou non.

Pour illustrer ce fonctionnement dans le cas de l’IM, l’exemple d’une image en niveaux de gris où chaque pixel est représenté par une valeur avec 0 pour noir et 1 pour blanc sera pris. S’il y a 1000 pixels, il est possible d’avoir 1000 neurones d’entrées, donc 1000 valeurs. Chaque neurone prend une valeur numérique qui dépend de toutes ses connexions entrantes en fonction de leur poids associé. L’information est propagée d’une couche à l’autre, jusqu’à la dernière. Chaque neurone de la couche de sortie aura un degré d'activation qui représente le pourcentage de chance que l’image médicale corresponde à un cas de figure. Au début de l'entraînement les résultats obtenus seront très différents de ceux attendus, mais l'apprentissage permettra de corriger cela et le réseau sera capable d’interpréter une image sans se tromper et pourra même analyser des images qu’il ne connaît pas. Si l'entraînement a été efficace, les résultats donnés seront ceux attendus. Par exemple, si l'image analysée représente une tumeur (résultat attendu), et que le résultat donné affirme avoir trouvé une tumeur sur les pixels la représentant, le résultat est alors positif [10]. A savoir que l'IA est toujours en apprentissage, même déployée dans un équipement d’imagerie et lors d’une mauvaise interprétation, le radiologue peut signaler l’erreur au système.

Un élément très important à prendre en compte est la standardisation des données d’imagerie au format DICOM. C’est-à-dire que ces données doivent, par exemple, être issues de la même modalité d’imagerie et de faible variabilité. Sans cela, la fiabilité des résultats serait fortement impactée, et il en va de même pour la confiance que portent les radiologues envers la solution.

L’IA peut être utilisée dans tous les domaines en santé impliquant un grand nombre de données. L’IM met en jeu des données diverses et nombreuses avec de potentiels gains non négligeables pour le patient justifiant de l’apport de l’IA.

II - Apports et limites de l’Intelligence Artificielle pour l’Imagerie Médicale

L’IA en IM peut représenter une opportunité et une véritable aide au quotidien pour les radiologues avec de réels apports qui vont être analysés.

A) Apports et intérêts de l'IA en IM

Depuis de nombreuses années, différents processus mathématiques ont tenté de faciliter le travail des médecins dans la classification et le diagnostic des pathologies. Plusieurs systèmes de Détection Assistée par Ordinateur (DAO) ont été mis en place afin de permettre la détection de divers cancers en radiologie par exemple [14]. La DAO permet de proposer des diagnostics pour orienter le médecin, mais contrairement à l’IA, ses performances restent limitées et rigides puisqu’elles sont seulement basées sur les données fournies à l’algorithme [18]. De plus, des études cliniques ont montré que ces méthodes génèrent plus de faux positifs que les médecins eux-mêmes [19], résultant donc en des examens complémentaires et un temps d’évaluation plus long [14]. C’est pourquoi aujourd’hui, grâce à la très grande quantité de données médicales disponibles, la combinaison de la DAO à du Deep ou Machine Learning pourrait permettre une meilleure efficacité de traitements.

En effet, avec l’exemple de l’IA Boneview proposée par Incepto, cette dernière permet de diminuer de 30% les fractures manquées et augmente la spécificité (de 5%) ainsi que la sensibilité (de 12%) chez l’ensemble du personnel de santé. De plus, de manière plus détaillée, Boneview permet non seulement d’améliorer les performances des radiologues (diminution des fractures manquées de 22% et augmentation de la spécificité de 3%) mais également celles des urgentistes qui sollicitent souvent l’IM (diminution des fractures manquées de 34% et augmentation de la spécificité de 7%). Il y a une différence logique quant à l’impact de l’IA sur les différents praticiens hospitaliers avec une amélioration plus légère pour les radiologues, étant plus expérimentés. Enfin, l’IA a permis de réduire la quantité de faux positifs par patient sans fracture de 41,9% et le temps moyen de lecture de 15,0% [20].

Basée sur les méthodes de Deep et Machine Learning, l’IA peut aller jusqu’à la détermination des limites d’un organe ou d’une lésion, l’interprétation de radiographies pulmonaires [21], la détection de tumeurs cérébrales [22] ou de cancers de la prostate par exemple. L’IA permettrait même d’aller plus loin en classifiant les maladies en risque faible/élevé avec un bon/mauvais pronostic [23].

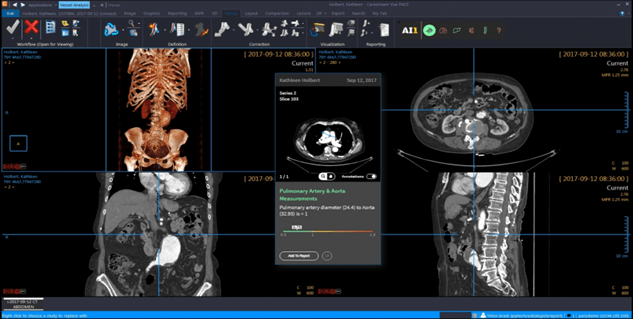

L’IA peut donc être un réel outil pour les radiologues, leur permettant non seulement de gagner du temps, mais aussi d’avoir un dispositif de vérification et d’analyse sur lequel se baser. Au lieu de remplacer les outils déjà utilisés par les radiologues, l’IA peut être intégrée au PACS - système de gestion électronique des images médicales - communément utilisé en radiologie via les logiciels Carestream (voir Figure n°9) ou AW Server de chez General Electric par exemple. Ces derniers permettent entre autres de déterminer de manière automatisée la densité osseuse, détecter les foies gras, les emphysèmes pulmonaires et les fractures de compression [24]. D’autres fonctionnalités de mesure sont possibles telles que l’analyse du flux sanguin tissulaire, du volume et de la perméabilité capillaire, avec détection automatique de la fonction d'entrée artérielle et de la fonction de sortie veineuse tout en favorisant un affichage automatique des résultats sous forme de cartes et de tableaux [25]. Les logiciels basés sur l’IA pourraient donc devenir, après maîtrise de ceux-ci par les radiologues, leur principal moyen d’analyse des résultats des patients.

Figure n°9 : Image de Carestream-PACS utilisé avec des outils d’IA (source : carestream.com)

De nombreuses voies d’avenir s'ouvrent aujourd’hui grâce à l’IA. La radiomique, méthode permettant de trouver des biomarqueurs diagnostiques, pronostiques ou prédictifs à partir d’extraits d’images radiologiques, est encourageante [21]. Cette méthode permet d’obtenir des biomarqueurs d'imagerie utiles pour l’administration des thérapies appropriées. L'IA peut soutenir l'analyse des caractéristiques radiomiques et les corréler à d'autres données (protéomique, génomique etc...) [26].

Par ailleurs l’IA peut apporter une aide administrative dans le secteur de la santé à travers une prise en charge des différentes données du patient et de leurs formats. En effet, au vu de l’importante production de données dans le secteur médical, l’IA pourrait permettre une exploitation efficace des informations du patient provenant de données de formats différents comme des comptes rendus, des analyses biologiques ou encore des imageries par exemple, pour accélérer la prise en charge du patient [27].

Enfin, un exemple concret et porteur d'espoir est celui de l’équipe du Professeur de neuro-imagerie avancée, Roland Wiest, à l'Université de Berne, en Suisse. Ils ont réussi à mettre en place une technique entièrement automatique basée sur l’IA afin de segmenter les images de patients atteints de glioblastomes. Cette technique est basée sur le Machine Learning et sur une nouvelle stratégie de compartimentation des tissus pour la segmentation des tissus. Ce système permet une segmentation complète des compartiments tumoraux (régions nécrotiques, actives et œdémateuses), des tissus sains, ainsi que des structures sous-corticales - utiles pour la neurochirurgie et la radiothérapie. En se basant sur cette technique, ils ont développé un outil logiciel appelé BraTumIA (Brain Tumor Image Analysis), qui effectue une segmentation entièrement automatique du tissu tumoral cérébral en cinq minutes environ. Ils ont également utilisé l’IA (Machine Learning) pour caractériser des lésions cérébrales des accidents ischémiques cérébraux ainsi que prédire l'issue la plus probable d'une intervention de thrombectomie mécanique réussie ou non [28].

Malgré les nombreux apports possibles de l’IA à l’IM, cela engendre tout de même des enjeux et risques à considérer.

B) Enjeux et risques liés à l’IA dans l’IM

Les termes d’IA et d’IM étant explicités, il faut désormais se demander quels sont les enjeux et risques se trouvant derrière l’association de ces deux domaines.

- Enjeux

L’intégration de l’IA dans l’IM présente de réels avantages, et ce dans plusieurs aspects grâce aux apports expliqués précédemment qui montrent la puissance technique et technologique de l’IA.

D’un point de vue thérapeutique, l’IA dans l’IM permet d’améliorer le diagnostic délivré par le radiologue qui pourra adapter au mieux le traitement prescrit au patient. De plus, les résultats sont délivrés bien plus rapidement car la machine peut prendre en compte les différentes modalités, analyses laboratoires et possibles biopsies du patient et le faire de manière plus rapide que l’Homme. Ainsi, cela réduit le temps d’attente du patient entre son examen et la délivrance des résultats après l’expertise du radiologue - la reconstruction de l’image, l’interprétation et la dictée pouvant aller de 30 minutes à 90 minutes, voire une journée et plus dans certains cas s’il y a beaucoup d’affluence. Grâce à cette accélération du processus, le patient pourra être mis plus rapidement sous traitement avec un suivi approprié.

Il y a également des bénéfices stratégiques avec un gain de temps considérable pour le radiologue qui pourra déléguer des tâches à l’IA et se concentrer sur d’autres missions. De plus, avoir à disposition une IA peut permettre de participer à la reconnaissance d’un établissement en favorisant sa renommée. Tout comme les hôpitaux ayant des robots chirurgicaux, cela peut montrer la puissance économique d’un établissement. Cela pourrait donc attirer davantage de patients à se faire soigner dans le centre de santé.

Ce dernier argument rejoint les enjeux économiques dans le cas des établissements à but non lucratif dont le but est de faire du profit. En effet, si le principe du gain de temps est repris, alors le service d’IM peut faire passer davantage d’examens médicaux aux patients, il y a donc une possibilité d’optimiser les coûts. En effet, un examen de scanner est coûteux. Ainsi, il est bien plus rentable de faire passer un maximum de patients. Cela est aussi en accord avec le besoin d’augmenter la disponibilité des équipements d'imagerie pour les patients.

Tous ces enjeux et la polyvalence de l’IA réunis permet de faire de l’IA un outil de diagnostic puissant et ayant un fort potentiel pour aider au mieux le radiologue. Cependant, cette solution technique engendre malgré tous des risques à ne pas négliger.

- Risques

Lors de l’achat d’un nouveau DM, il est important de se référer à « la matrice d’évaluation des risques et l’analyse des bénéfices-risques » [29] afin d’anticiper les difficultés pouvant survenir et, dans le meilleur des cas, trouver des solutions à ces problèmes.

L’inconvénient majeur de l’IA dans l’IM du côté diagnostic est le manque de justification. En effet, l’attente principale du radiologue est d’avoir un outil fiable. Or l’IA n’est pas dans la capacité de fournir une justification quant aux diagnostics établis : il n’est pas possible de remonter l’algorithme et savoir quels éléments ont été pris en compte pour parvenir à cette décision. Ce manque d’informations cruciales remet en question la légitimité de l’outil. De plus, il arrive que l’IA se trompe dans ses constats et fait des erreurs que même un jeune médecin n’aurait pas fait, ce qui décrédibilise la puissance de l’IA et pourrait mettre des radiologues dans une position juridique délicate en cas d’erreur médicale. En plus de cela, elle ne peut pas s’appuyer sur les antécédents du patient. Enfin, l’IA s’améliorant en se basant sur une base de données composée de clichés d’une haute qualité, il est difficile pour elle de progresser et donc tout à fait compréhensible que le radiologue se pose des questions sur la manière dont elle compte se perfectionner.

L'importation d’une IA engendre également des risques stratégiques avec la modification des organisations instaurées au sein du service d’IM et des compétences du personnel requises. Il peut donc y avoir des difficultés d’adaptation, avec un rebut des équipes. De plus, certains collaborateurs peuvent craindre qu’il y ait une modification des missions attitrées. Par ailleurs, il est aussi possible que certains hôpitaux soient davantage sollicités que d’autres, ce qui pourrait créer un afflux dans un cas, et une désertification dans d’autres. Enfin, une question se pose sur les données des patients : comment sont-elles gérées et protégées ? Une étude est à faire sur l’implantation d’un tel système qui requiert certainement un système de sauvegarde de ces données.

Les derniers aspects non négligeables à aborder sont les risques économiques. Les services d’IM sont déjà considérés comme les plus onéreux en raison du prix des DM et des installations spécifiques requises pour bâtir les salles. En optant pour une IA, il faut aussi bien comprendre le coût réel qu’elle implique. Ces critères économiques ont été vus auparavant et après réflexion, la rentabilité économique de l’IA ne se fera pas avant des dizaines d’années [30].

Il y a donc de nombreux enjeux et risques à prendre en compte dans un domaine où travaillent en coopération divers acteurs.

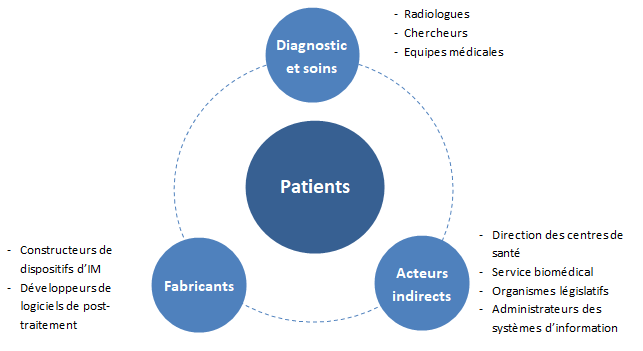

C) Acteurs

Cette partie vise à définir les différents acteurs concernés par l’IA dans l’IM dans la sphère des fabricants, protagonistes du diagnostic et personnes indirectement concernées.

Diagnostics et soins

- Patients : Les patients sont concernés par l’IA car leurs images sont analysées par des radiologues qui utilisent souvent des aides au diagnostic. L’enjeu pour le patient est directement lié à sa santé et particulièrement aux urgences ou pour la détection de cancers. La qualité des diagnostics est liée à la manière de traiter leurs images, et pour la prise en charge médicale qui suivra s’il est nécessaire. De plus, en cas d’urgence le délai de prise en charge ou la pose de diagnostic peuvent être raccourcis.

- Radiologues : L’IA est employée dans l’étude d’IM dans des stades d’étude pré-cliniques et cliniques, et les radiologues sont les principaux concernés par cette avancée. Elle assiste le radiologue et lui permet de simplifier et accélérer la lecture d’IM. L’arrivée de l’IA a fait subir lors des quatre dernières années une réelle mutation aux radiologues et devient aujourd’hui inévitable pour ce métier d’après une interview avec un spécialiste de l’IA. L’apport de l’IA dans le métier de radiologue se caractérise en un gain de temps sur l’analyse de images, et en un gain en confiance des diagnostics car ils ont le contrôle d’un logiciel en plus. L’IA diminue le stress qui pèse sur eux en limitant les erreurs qui sont humaines mais lourdes en responsabilité et qui peuvent mener à des burn-out. Dans une enquête de la société française de la radiologie avec le soutien de GE Healthcare à l’occasion des journées francophones de la radiologie de 2017, 82% des radiologues pensent que l’IA peut améliorer la pertinence des décisions cliniques [31]. Ce chiffre montre que des outils d’IA sont bien reçus par la profession. D’après un entretien réalisé auprès d’un interne en radiologie, les logiciels d’IA sont utilisés assez régulièrement (notamment BoneView de Gleamer pour la détection des fractures) et sont vus comme une sécurité supplémentaire permettant d’augmenter la sensibilité. Les IA qui leur sont particulièrement utiles sont celles permettant de classer les examens prioritaires (une image radiographique affichée comme pathologique par exemple). De plus, il a précisé que les logiciels d’IA sont utilisés systématiquement dans certaines situations (en plus des analyses réalisées par les radiologues) telles que pour la recherche de nodules pulmonaires afin de limiter les erreurs. Le retour réalisé par cet interne a été très positif par rapport aux futures utilisations de l’IA en IM. Cependant, il est important de prendre en compte la diversité des avis des radiologues aujourd’hui et notamment les réticences de certains vis-à-vis des logiciels d’IA.

- Chercheurs : Les chercheurs sont concernés par les avancées en termes d’innovations technologiques et l’IA est une avancée significative dans le domaine de l’IM. Ils ont un rôle dans le développement des nouveaux outils et leurs utilisations ainsi que le croisement entre le domaine technique qui concerne les DM et les outils d’aide au diagnostic.

- Équipes médicales : Le corps médical travaille en lien avec le service d’IM et délivre des soins qui dépendent directement du diagnostic des radiologues.

Fabricants

- Constructeurs de dispositifs d'IM : Dans un milieu aussi concurrentiel que celui des DM, celui des dispositifs d'IM a une place importante et les options vendues avec un produit peuvent faire pencher la balance et influencer le marché. L’IA est un élément important qui est intégré dans les logiciels de post-traitement des images avec plusieurs applications souvent optimisées pour leurs équipements.

- Développeurs de logiciels de post-traitement : Les développeurs de logiciels sont des entreprises à taille variable ou des start-ups et ils jouent un rôle essentiel dans l’innovation, qui représente un marché très concurrentiel où la production de nouveautés peut créer la différence. Les IA sont beaucoup utilisées dans le développement de nouveaux outils destinés aux radiologues et leur conception dépend de chaque modalité et type d’anatomie qui est observée.

Acteurs indirects

- Direction des centres de santé : La direction a un rôle de validation ou non des achats. Elle peut choisir de mettre en avant l’innovation en employant des techniques ou équipements novateurs qui n’ont pas été adoptés par l’ensemble des établissements par exemple.

- Service biomédical : Le service biomédical est le service chargé des achats, puis de l’entretien des solutions techniques qu’ils fournissent aux différents services de l’hôpital.

- Organismes législatifs : Les organismes législatifs entrent en jeu lors de la création d’un DM. Si un logiciel utilisant l’IA est un DM, il est soumis à la même réglementation que les autres DM avec les règles de classifications associées aux risques.

- Administrateurs des systèmes d’information : Ils s'occupent des systèmes informatiques et doivent s’assurer que les informations entre les différents systèmes informatiques de l'hôpital peuvent être communiquées entre eux.

L’IA concerne donc plusieurs acteurs de la santé qui interviennent à différents moments dans l’offre de soins (voir Figure n°10).

Figure n°10 : Diagramme des différents acteurs de l’IA en IM (source : auteurs)

III - L'offre en IA proposée aux radiologues

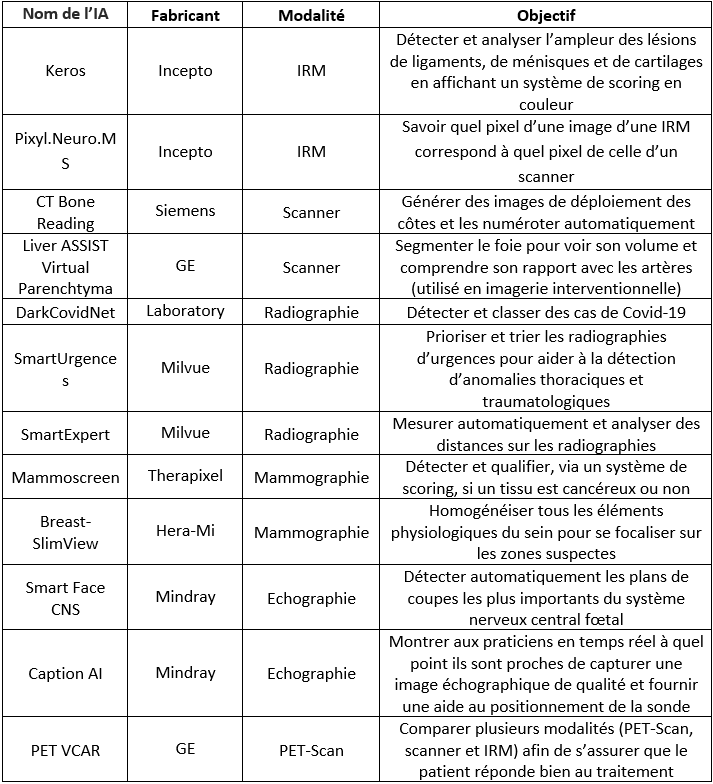

Le benchmark qui suit ne sera pas une liste exhaustive des IA dans l’IM car le nombre de logiciels développés ne cesse d’évoluer : les recenser sortirait du but de ce projet. Une liste d’IA qui sont commercialisées pour donner des exemples dans des applications variées en IM seront présentées. Les interviews qui ont été réalisées sont également des sources d’informations importantes pour ce benchmark.

A) Méthodologie

Dans le cadre des recherches pour ce projet, et dans le but de se l’approprier en profondeur et de réaliser un benchmark, six interviews avec des acteurs du milieu de l’IA dans l’IM ont été réalisées. Parmi ces personnes, des vendeurs d’IA dans des startup, des développeurs travaillant chez des constructeurs et des spécialistes de différentes modalités utilisant l’IA ont accepté de répondre à des questions en lien avec ce projet. La diversité des profils interrogés étant très riche, voici un résumé des informations acquises lors des interviews réalisées dans le cadre de ce rapport.

Les éléments obtenus lors des entrevues concernent les types d’IA, en fonction des applications de ces dernières, et principalement l’amélioration de l’image et l’aide au diagnostic lors du post-traitement. Il existe également plusieurs indicateurs de performance d’une IA, détaillés dans ce dossier dans la partie évaluation. Des documentations traitant de l’IA d’un concepteur d’IA en IM ont également été fournies lors d’une interview, ainsi que des informations au sujet des bases de données qui aident à entraîner une IA et l'importance des annotations. En effet, un logiciel d’IA a besoin d’avoir des précisions sur les images qui lui sont données pour être efficace et la qualité des annotations sera directement liée à celle des analyses de l’IA.

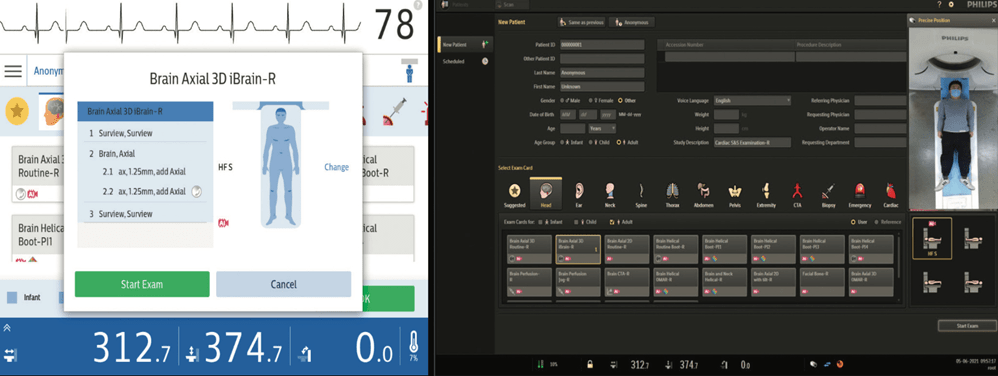

B) Acquisition de l'image et IA

L’IA peut intervenir dès l’acquisition de l’image. Selon la modalité, différentes applications sont possibles : l’IA a pour but d’améliorer l’installation du patient, simplifier les actions des manipulateurs en radiologie et réduire les doses de rayons X reçues par le patient.

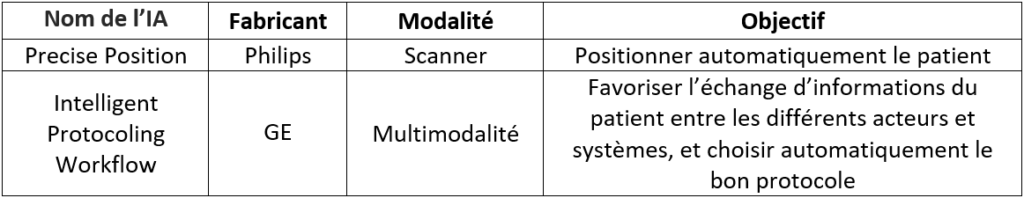

Par exemple en Scanner, le logiciel Precise Position de Philips (voir Figure n°11) permet, à l’aide d’une caméra fixée au plafond au-dessus de la table qui va détecter différents points d’anatomie en s’appuyant sur les profondeurs et couleurs, de positionner automatiquement le patient de façon à pouvoir prendre des clichés dans les meilleures conditions possibles. Cela évite ainsi d’obtenir des images non-interprétables et de recommencer l’installation du patient, faisant gagner jusqu’à 23% du temps de l’acte médical [32].

Figure n°11 : Interface du logiciel Precise Position de Philips (source : Philips.fr)

De plus, il est possible d’éviter d’irradier, pour les modalités employant les rayons X, une zone qui ne devrait pas être exposée aux rayons grâce à cette technologie, d’après un spécialiste de la modalité de chez Philips. En effet, en choisissant automatiquement le bon site à visualiser dès la première séquence de l’examen, il ne sera pas nécessaire de refaire d’autres clichés. Ainsi, le temps durant lequel le patient est soumis aux rayons est réduit et leur diffusion dans la zone de l’endroit irradié sera minimisée. L’IA peut améliorer la qualité d’une image pour la rendre plus lisible en atténuant le bruit. Sachant que la qualité d’une image est liée à la durée d’un examen, il est possible de limiter cette durée et la dose de radiations absorbée par le patient. Pour les examens d’IRM, cette amélioration de la qualité de l’image permettra de diminuer la durée des examens qui est relativement longue (15 à 30 min).

L’utilisation de l’IA ne s’arrête pas là, elle peut également être employée dans le recalage entre les images. Lorsqu’un même patient réalise plusieurs clichés de modalités différentes, le radiologue doit toutes les interpréter et il peut être difficile de se repérer. Chez GE, une IA peut lancer une analyse automatique entre deux modalités différentes : il est ainsi possible de savoir quel pixel d’une image d’une IRM correspond à quel pixel de celle d’un scanner.

Enfin, une autre application est l’amélioration du workflow.Cela permet d’accélérer la prise en charge du patient et la pose de son diagnostic en favorisant l’échange de ses informations entre différents acteurs et systèmes. Par exemple chez GE, l’Intelligent Protocoling Workflow [33] permet au docteur généraliste recevant un patient ayant des douleurs au foie d’envoyer directement son ordonnance à un hôpital pour lui faire passer un scanner de l’abdomen. L’Intelligent Protocoling va par la suite analyser les données reçues et, en fonction des procédures de l’établissement, choisir parmi plusieurs protocoles d’acquisition celui qui sera le plus adapté. Ce protocole est ensuite envoyé au scanner et la partie à visualiser sera sélectionnée automatiquement, qui, dans ce cas, sera l’abdomen. Les données récoltées seront ensuite transmises au radiologue. Cette automatisation permet de gagner du temps et d’améliorer la qualité de l’examen global.

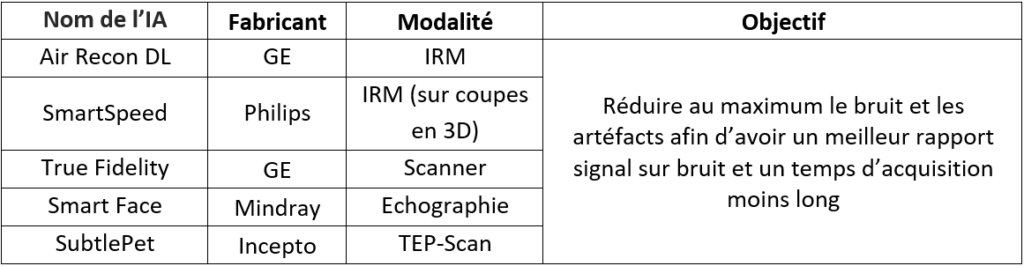

C) Reconstruction de l’image et IA

L’IA peut également être utilisée lors de la reconstruction de l’image afin de réduire au maximum le bruit et les artéfacts qui peuvent parasiter le signal : il est alors plus simple de travailler dans le domaine spectral. Pour cela, des transformations de Fourier sont réalisées et des fréquences sont ainsi obtenues. L’IA s’appuie sur une base de données remplies d’images bruitées avec des artéfacts récurrents et est entraînée pour les reconnaître via leurs fréquences : il s’agit dans ce cas du Deep Learning. De cette manière, l’IA est capable d’éliminer automatiquement ces éléments indésirables lors de la reconstruction de l’image qui, une fois affichée au radiologue, sera moins floue avec un rapport signal sur bruit (S/B) augmenté, et donc avec moins de bruit et d’artéfacts. Par ailleurs, le temps d’acquisition peut être réduit, passant de 1 minute et 55 secondes à 1 minute et 18 secondes grâce à la technologie Air Recon DL de GE en IRM par exemple [34] (voir Figure n°12).

Figure n°12 : Application de l’IA Air Recon DL de GE, permettant de réduire le bruit et le temps d’acquisition en scanner (source : gehealthcare.com)

Pour le moment, tous les logiciels d’IA de reconstruction d’images déjà commercialisés ne fonctionnent que sur celles qui sont en 2D, puis la reconstruction en 3D est possible. Philips compte bouleverser ce marché dans les années à venir en proposant de travailler directement sur les images en 3D grâce à SmartSpeed. Concernant le prix des IA, il peut varier grandement selon les fonctionnalités : chez Philips, il va de 50 000 € à 100 000 € pour les IRM d’après un spécialiste de la modalité de chez Philips. L'IA en IRM est davantage utilisée par rapport aux autres modalités car l’acte médical est celui qui est le plus coûteux et il y a une multitude d’images issues des différentes séquences. Cependant, il y a de nombreux logiciels pour chaque modalité ayant tous la même finalité : reconstruire l’image en augmentant au maximum le S/B. GE fournit, entre autres, deux logiciels permettant d’améliorer la qualité de l'image : Air Recon DL en IRM et True Fidelity en Scanner. Il existe également d’autres logiciels avec le même but en échographie tel que Smart Face de Mindray [35] ou SubtlePet de Incepto en TEP-Scan [36].

L’IA utilisée pour la reconstruction de l’image s’avère donc utile et permet de faciliter la lecture pour le radiologue en proposant un meilleur rendu. D’autres types d’IA ont une toute autre utilisation et sont déjà utilisés en clinique depuis un moment : il s’agit des IA d’analyse de l’image.

D) Analyse de l’image et IA

Les IA d’analyse de l’image existent et sont utilisées depuis longtemps comparées à celles de reconstruction de l’image qui sont plutôt récentes, bien que toutes les deux ont recours au Deep Learning. Dans un premier temps, l’image va être classifiée en attribuant un label à chaque image. Puis vient une partie bien plus intéressante qui est la détection d’une position d’intérêt : il est ainsi possible de demander à un réseau de neurones de détecter une tumeur par exemple. Le champ d’application de l’IA s’agrandit considérablement dans ce domaine car il est possible de réaliser une multitude d’actions. Chez GE (General Electric) par exemple, il existe un grand pôle de développement autour de la segmentation qui permet de séparer différents organes dans une image tout en les classifiant, ces informations ont été acquises lors d’un entretien avec un développeur d’IA de chez General Electric. Cela est rendu possible grâce au fait que l’IA “se demande” à quel organe appartient chaque pixel de l’image et va donc les classer en fonction de cela. Il est également possible d’obtenir entre autres une labellisation automatique des éléments recherchés, une détection des tumeurs, etc. Par la suite, des exemples d’application de l’IA en analyse de l’image par modalité sera présentée.

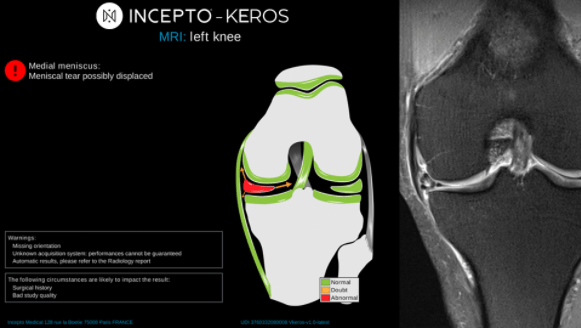

- IRM

Keros de Incepto permet de détecter et analyser l'ampleur des lésions de ligaments, de ménisques et de cartilages en affichant un système de scoring en couleur (voir Figure n°13). Dans la partie à gauche, des indications cliniques concernant la blessure du patient sont données. Pour aider le radiologue, une représentation en 2D de la zone observée est reproduite avec l’image de base sur la droite. Sur ce modèle, les zones normales sont en vert tandis que les zones qui ne le sont pas sont signalées en rouge. Cela permet, en un coup d’œil rapide, d’identifier l’endroit à risque. De plus, ce logiciel est également compatible avec les PACS et consoles de revue, permettant ainsi aux radiologues d'obtenir un rapport détaillé ou synthétique au choix [37].

Figure n°13 : Keros, IA de détection des lésions du genou pour l’IRM (source : incepto-medical.com)

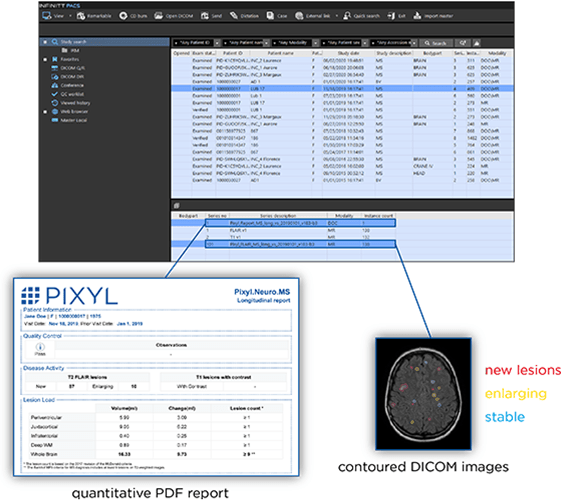

Pixyl.Neuro.MS (voir Figure n°14) est une autre IA d’Incepto permettant cette fois-ci d’être une aide au diagnostic et d’assurer le suivi de la sclérose en plaques d’un patient. Après une IRM du cerveau, chacune de ses régions est analysée : le nombre de lésions est compté et leur volume global est calculé. En plus de cela, les contours de ces lésions sont mis en valeur sur les images au format DICOM grâce à une légende en couleur qui permet de différencier les nouvelles lésions, celles qui ont augmenté en taille et celles qui sont stables. Ces résultats sont visibles dans l’espace de lecture habituel du radiologue, ce qui permet de ne pas le déstabiliser, et au contraire lui fournir davantage d’informations. De la même manière que l’IA Keros, un rapport détaillé ou synthétique au choix est automatiquement généré [38].

Figure n°14 : Pixyl.Neuro.MS, IA d’aide au diagnostic et du suivi de la sclérose en plaques (source : incepto-medical.com)

- Tomodensitométrie - Scanner

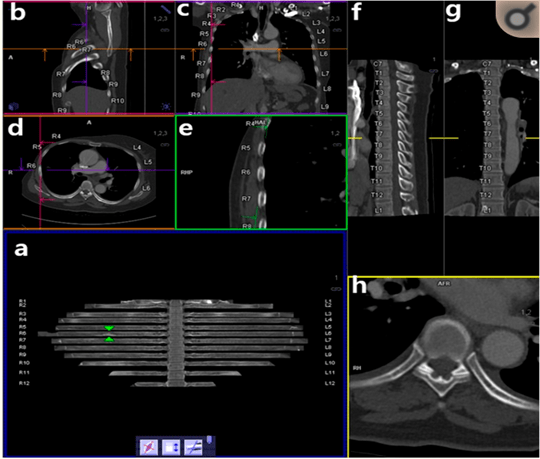

L’IA CT Bone Reading de Siemens permet de générer des images de déploiement des côtes et numérote automatiquement ces dernières ainsi que les épines thoraciques ce qui facilite la tâche du radiologue dans la détection des métastases osseuses thoraciques du cancer du sein [39]. Il est également possible d’ajouter des notes directement sur ces labels. Cette IA propose différentes vues possibles, ce qui offre une vision globale au radiologue. Sur la figure n°15 ci-dessous, l’image a) représente les côtes déployées. Ces dernières peuvent être orientées dans plusieurs sens via la molette de la souris ou en cliquant sur les icônes en bas de l’écran. Si le radiologue clique sur une zone particulière de l’image a), alors des coupes sagittales coronales, transversales et perpendiculaires des côtes sont affichées en même temps (respectivement : images b), c), d) et e)). Les coupes sagittales et coronales des vertèbres thoraciques sont également consultables sur les images f) et g). Enfin, l’image h) représente une vue zoomée transverse des dernières coupes.

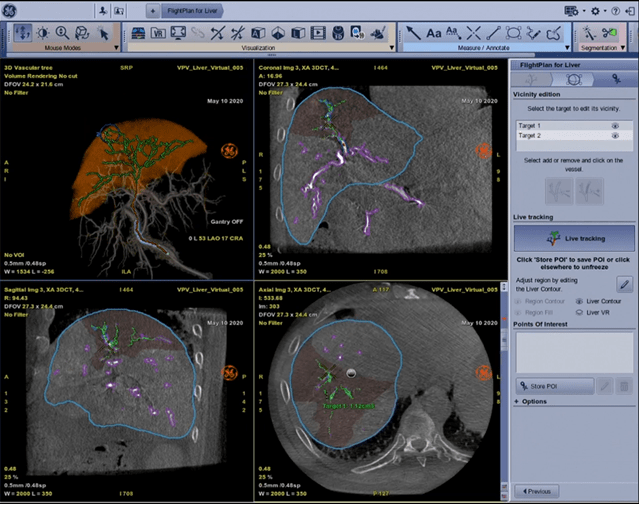

Figure n°15 : CT Bone Reading, IA de labellisation des côtes (source : siemens-healthineers.com)

En imagerie interventionnelle, le médecin peut injecter au patient des produits qui ont pour vocation de tuer les cellules tumorales comme les chimioembolisations et les radioembolisations. Pour cela, un tube cathéter est inséré dans le patient au niveau fémoral et remonte jusqu’au foie. Pour voir où le médecin se situe et savoir s’il est au bon endroit, des rayons X sont envoyés et récupérés via des détecteurs de l’autre côté. Le médecin peut ainsi voir les images en temps réel. De plus, il est possible de tourner le tube autour du patient afin d’avoir des coupes en 3D. Désormais, GE propose de segmenter le foieavec son logiciel Liver ASSIST Virtual Parenchyma [40] pour que le médecin puisse automatiquement voir le volume du foie du patient et comprendre le rapport entre les artères qu’il voit et le foie. Il est également possible de savoir quel vaisseau est attaqué grâce à une analyse des vaisseaux et du bord du foie. Sur la figure n°16 ci-dessous, quatre vues sont affichées simultanément : la première représente une représentation en 3D du foie avec une mise en valeur des artères et de la zone tumorale entourée en bleu. Puis respectivement, les coupes coronales, sagittales et axiales sont affichées.

Figure n°16 : Liver ASSIST Virtual Parenchyma, IA de segmentation du foie (source : gehealthcare.com)

- Radiographie

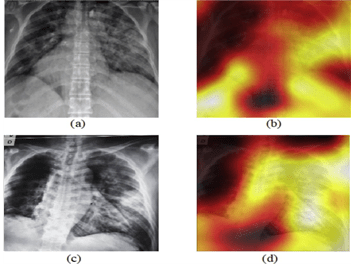

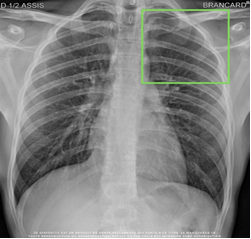

Étant donné le contexte actuel avec la crise sanitaire, la Covid-19 est une grande préoccupation au sein des hôpitaux. Encore une fois, l’IA a su se rendre utile en étant capable de détecter et classer des cas de Covid-19 en utilisant des images radiographiques couplées à des cartes thermiques montrant une plus grande zone de chaleur dans les poumons des cas de Covid (voir Figure n°17). Tout d’abord, le modèle d'apprentissage profond DarkCovidNet [41] a été entraîné pour classer les images radiographiques en trois classes : Covid-19, No-Findings, Pneumonia. Puis, il a finalement été entraîné à ne détecter que deux classes : Covid-19 et No-Findings.

Figure n°17 : DarkCovidNet, IA de détection et classification du Covid-19 (source : sciencedirect.com)

Quant à SmartUrgences de Milvue, l’objectif est de prioriser et trier les radiographies d’urgences pour aider à la détection d’anomalies thoraciques et en traumatologie. L’IA est donc capable de détecter des anomalies anatomiques afin de faire ressortir au radiologue les clichés qui devront nécessiter son attention (voir Figure n°18) avec les zones anormales encadrées en vert. Cette IA permet également d’établir des comptes rendus pré-documentés faciles et rapides. Milvue propose aussi SmartExpert, une IA qui permet de mesurer automatiquement et analyser en temps réel des distances sur les radiographies [42].

Figure n° 18 : SmartUrgences, IA de détection de pathologies thoraciques (source : challenges.fr/start-up/milvue.fr)

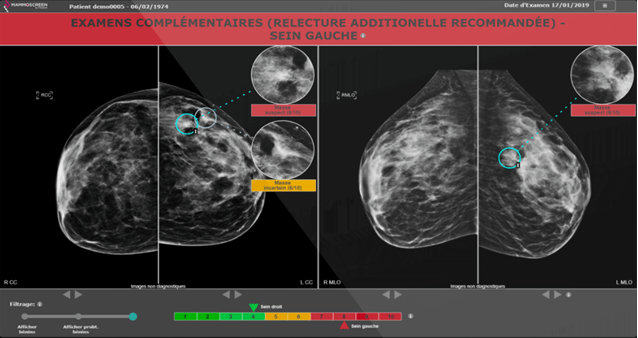

- Mammographie

En mammographie, le logiciel Mammoscreen de Therapixel est utilisé pour les cancers du sein afin de détecter et qualifier facilement, via un système de scoring, si un tissu est cancéreux ou non (voir Figure n°19). Pour cela, l'IA a été entraînée pour reconnaître des lésions cancéreuses. Sur la Figure n°19, quatre images représentant les incidences crânio-caudales et médiolatérales obliques de chaque sein sont affichées. Les masses seront entourées et accompagnées d’un score et d’une légende en rouge en cas de suspicions de tumeurs, et en jaune si l’IA est incertaine. Sur la partie haute de l’application se trouve une légende avec des recommandations adressées au radiologue, et en bas se trouve une échelle permettant d’identifier facilement quels sont les seins atteints. Il est également possible d’ajuster le filtrage [43].

Figure n°19 : Mammoscreen, IA de détection du cancer du sein (source : mammoscreen.com)

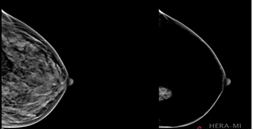

Dans la même optique, Breast-SlimView de la Hera-Mi permet d’homogénéiser tous les éléments physiologiques du sein (les vaisseaux, les tissus conjonctifs, la glande mammaire, les muscles et la graisse) afin de faciliter l’interprétation du radiologue en lui permettant de se focaliser sur les zones suspectes (voir Figure n°20) [44].

Figure n° 20 : Breast-SlimView, IA d’aide au diagnostic du cancer du sein (source : mammoscreen.com)

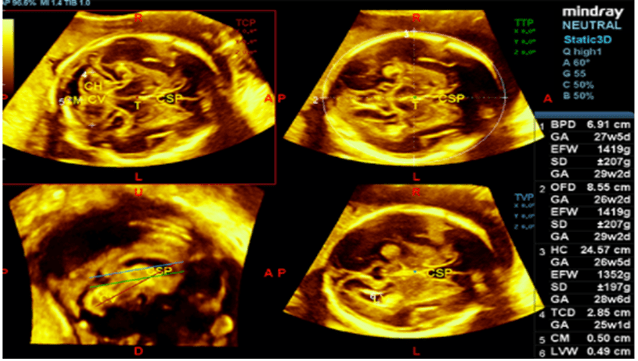

- Echographie

En échographie, le logiciel Smart Face CNS de Mindray permet de détecter automatiquement et avec précision les plans de coupes les plus importants du Système Nerveux Central fœtal (voir Figure n°21). Cela permet ainsi de faciliter le diagnostic et d’obtenir un maximum d’informations permettant d’assurer la bonne santé et le bon suivi du fœtus [35].

Figure n°21 : Smart Face CNS, IA de détection des meilleurs plans de coupes du SNC fœtal (source : mindray.com)

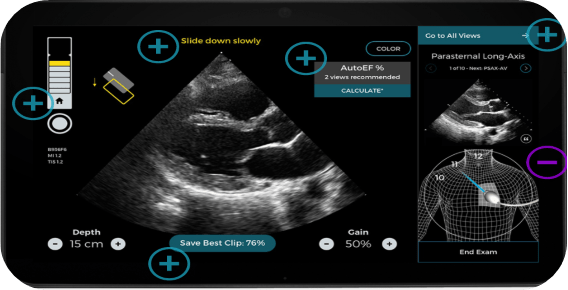

Caption AI permet quant à lui de guider les praticiens dans la réalisation d’examens échographiques cardiaques. Il montre aux utilisateurs en temps réel à quel point ils sont proches de capturer une image échographique de qualité et fournit une aide au positionnement de la sonde pour chaque examen (voir Figure n°22) grâce à l’indicateur de la qualité du signal de l’échographie en haut à gauche et les conseils destinés aux praticiens en haut au centre. Sur la droite, il est également possible de visualiser une image de référence et une indication de la zone à visualiser. De plus, pour les échographies cardiaques, il permet de calculer la fraction d'éjection (pourcentage de sang quittant le cœur chaque fois qu’il se contracte) [45].

Figure n°22 : Caption AI, aide à la réalisation d’échographies de qualité (source : captionhealth.com)

- PET-Scan

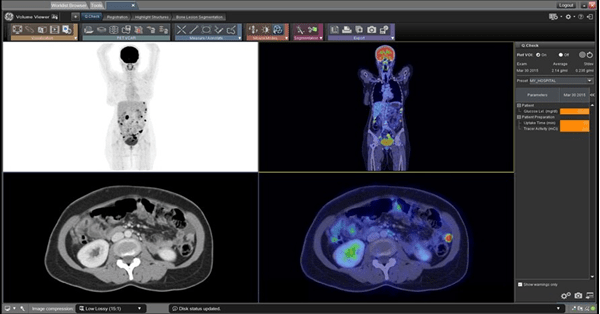

Concernant le PET-Scan, le logiciel PET VCAR de GE permet de comparer plusieurs modalités (PET-Scan, scanner et IRM) afin de s'assurer que le patient réponde bien au traitement qui lui a été administré (voir Figure n°23). Cela ressemble à la segmentation décrite précédemment, avec la correspondance des pixels [46].

Figure n°23 : PET VCAR, IA pour déterminer si le traitement du patient fonctionne (source : gehealthcare.com)

Il existe donc une multitude d’IA en IM, chacune ayant une finalité. Afin de mieux visualiser celles présentées précédemment, des tableaux récapitulatifs sont disponibles ci-dessous.

- Acquisition de l’image et IA

Tableau n° 1 : Exemples d’IA d’acquisition de l’image

D’autres applications existent en développement et permettent de superposer les pixels correspondant aux modalités d’IRM et de Scanner et augmenter ainsi les capacités de diagnostic et de vitesse.

- Reconstruction de l’image et IA

Tableau n° 2 : Exemples d’IA de reconstruction de l’image

- Analyse de l’image et IA

Tableau n° 3 : Exemples d’IA pour l’analyse d’images médicales

Toutes ces solutions présentées sont des outils d’aide au diagnostic : l’IA en tant que telle ne permet pas de délivrer un diagnostic, seul le radiologue est apte à le faire. L’IA peut néanmoins participer à un diagnostic dit prédictif en anticipant la progression d’une maladie en analysant la réponse au traitement du patient. Elle peut également permettre d’éviter des erreurs sur des clichés extrêmement difficiles ou au contraire très simples. En effet, l’erreur est humaine et peut survenir à tout moment, surtout lorsque l’on connaît les horaires et conditions de travail des radiologues qui peuvent être difficiles.

IV – Critères d’évaluation et limites de l’IA

A) Facteurs de décision pour l'achat d'une IA

Les radiologues peuvent se sentir submergés par les offres d’IA. Il est donc nécessaire qu’ils puissent s’appuyer sur des critères précis afin d’être guidés lors du processus d’achat. Pour cela, un guide nommé ÉCLAIR guidelines permet de les aider à mieux choisir l’IA qui leur conviendrait [29].

La première chose à faire avant d’acheter une IA est de définir le besoin des radiologues : il faut bien se demander dans quel cas ils souhaiteraient utiliser l’IA et ce qu’elle pourrait leur apporter. Étant donné que l’IA peut être utilisée pour différentes indications cliniques, il est donc aussi nécessaire de se pencher sur cette question. Cette étude globale permet ainsi d’instaurer un cadre et savoir dans quelle direction il faut aller. En effet, acheter une fonctionnalité qui ne sera pas utilisée serait une perte d’argent. Par la suite, il y a une analyse bénéfices-risques à faire car l’IA peut être sujet à des erreurs et dangers pouvant entraîner la responsabilité des radiologues. Pour cela, il est possible de se référer à « la matrice d’évaluation des risques et l’analyse bénéfices-risques dans le dossier technique réglementaire fourni par le fournisseur » [29].

Il y a également des contraintes matérielles qu’il faut prendre en compte. Tout d’abord, il est nécessaire d’avoir à disposition du matériel et des infrastructures informatiques compatibles et suffisamment performantes et puissantes avec l’IA. Cela peut rapidement faire augmenter les dépenses de l’hôpital. Il faut également prendre en compte les modules en option, l’installation logicielle et matérielle, la formation du personnel et les maintenances curatives et préventives. Il y a donc une réelle étude des coûts des équipements à réaliser. Côté logiciel, il faut également prévoir les futures mises à jour : seront-elles comprises lors de l’achat de l’IA ou faudra-t-il encore débourser ? Il en est de même pour la licence qui peut être acquise selon différentes formules : mensuelle, annuelle, à vie ou bien à chaque utilisation - Software as a Service (SaaS) [47]. Cette dernière et l’utilisation renouvelable par mois sont pour le moment les plus appréciées car l’IA reste une option coûteuse et elle n’est pas tout le temps utilisée par les radiologues.

Enfin, le côté évolutif de l’IA, s’appuyant sur des clichés de haute qualité, peut poser problème dans un établissement de santé où les images ne sont pas toujours parfaites. Afin de s’améliorer, l’IA doit respecter des critères de répétabilité et de reproductibilité qu’il faut donc considérer. De plus, il faut que l’IA soit compatible et intégrée au système PACS et facile à utiliser. En effet, si l’outil est difficile à prendre en main ou ne fonctionne pas bien en fond multitâche, cela peut créer des confusions pour l’équipe et donc retarder le diagnostic délivré suite à l’analyse des clichés.

Il y a donc plusieurs facteurs de décision à prendre en compte pour l’achat d’une IA en IM.

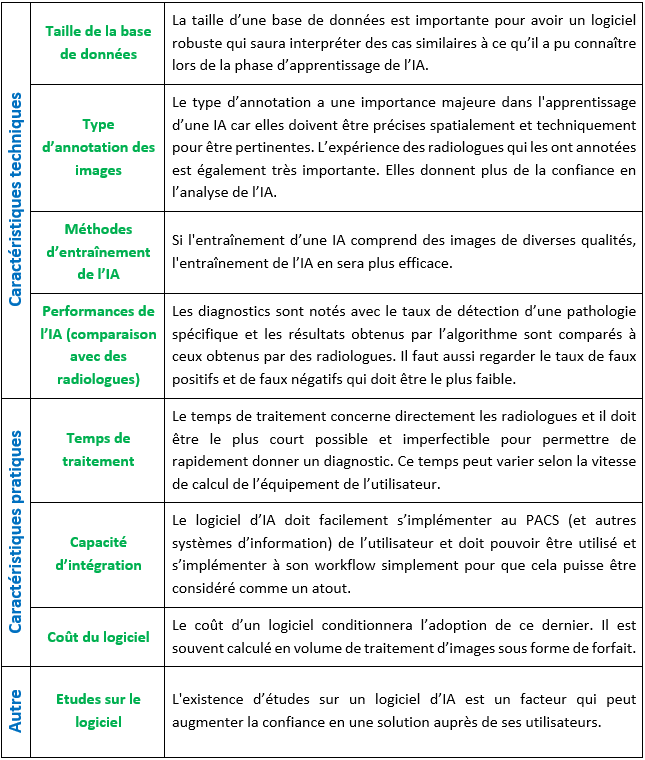

B) Critères d’évaluation d’une IA

De par le manque d’outils concrets, il n’est pas facile pour tous les radiologues d’évaluer les solutions d’IA qui leur sont proposées. Plusieurs points de réflexion sont proposés dans cette partie [48].

Comprendre les éléments clés de conception d’un logiciel permet de mieux définir ses points d’évaluation. Les logiciels d’IA gagnent en qualité et performance selon la taille de leur base de données et les critères d'entraînement. Il faut donc s’attarder sur ces points.

Comme présenté dans l’article « Donner un sens à l’intelligence artificielle : pour une strategie nationale et européenne » de M. Gautherot et al., il y a quatre critères très importants qui peuvent servir de points d’appui pour les futurs acquéreurs de solutions d’IA ou pour des éditeurs de logiciels qui auront besoin de comparer les produits de leur catalogue.

- La qualité de la base de données

Premièrement, il y a la qualité de l’apprentissage qui reflète celle de la base de données. La taille de cette base est importante car plus elle contient de données, plus l’IA apprend à partir d’informations et de mises en forme différentes, et moins il y aura d’inconnues. Cela permet de réduire le taux de faux positifs/faux négatifs ainsi que la probabilité que l’IA rencontre une situation qu’elle pourrait mal interpréter. De ce fait, l’IA parviendra plus facilement à analyser un nouveau cliché en s’appuyant de ce qu’elle aura déjà connu auparavant. Ce mécanisme est semblable à l’apprentissage humain : si un enfant apprend à reconnaître des images d’un animal vu sous différents aspects, il saura mieux le reconnaître la prochaine fois qu’il en verra un. Un autre élément essentiel est le fait que l’IA puisse s’entraîner sur des images de qualité différentes (plus ou moins bruitées) provenant de patients différents car cela améliore la représentativité de l’IA et elle sera ainsi capable de travailler sur des clichés de mauvaise qualité. Un utilisateur d’imagerie plutôt novice pourrait tout de même exploiter son image grâce à l’IA, même avec un cliché moins bien réussi qu’un expert.

- La qualité des annotations

Le second grand axe d’évaluation est l’annotation des données. Cette étape a lieu lors de la prise d’un cliché : les éléments d’intérêt comme la présence d’une fracture ou d’une tumeur par exemple sont renseignés, ce qui permet d’aider et d'aiguiller le diagnostic de l'IA. Des annotations de bonnes qualités sont précises spatialement et ne comportent pas d’erreur. Elles sont faites par des radiologues spécialistes et experts dans leurs domaines, et auront donc plus de valeur que celles de néophytes. Si le processus d'annotation comprend plusieurs radiologues experts, l’utilisateur aura une plus grande confiance et la qualité sera d’autant plus améliorée. C'est pourquoi il est important de connaître les profils des individus (métiers, expériences, compétences...) ayant annoté les données. Les données sont vérifiées plusieurs fois, ce qui fait que les défauts d’annotations sont moindres. Cela prend beaucoup de temps et représente donc un point d’évaluation essentiel : la robustesse de la solution en dépend.

- Méthode d’entrainement

Le troisième point d’évaluation est l'entraînement qui conditionne l’apprentissage. Pour augmenter les performances de l’IA, il est difficile mais bon d’utiliser des images de mauvaise qualité pour élargir son champ d’action. Cela se fait souvent avec du Deep Learning, il faut donc un volume de données important et il peut être judicieux de se demander d'où viennent les données. Dans le cas d’un constructeur, l'entraînement se fait souvent sur des clichés de leurs machines d’imagerie alors que pour les IA développées par des petites entreprises, il y a souvent des partenariats. La diversité des origines des données permet d’augmenter la qualité de l’apprentissage. Si l'entraînement ne se fait qu’avec des données similaires, l’IA pourra difficilement fournir des résultats corrects. Il faut donc vérifier que lors du développement du logiciel, des jeux de données différents aient été utilisés : un jeu pour l'entraînement, un second pour perfectionner les décisions de l’IA et un dernier pour évaluer l’exactitude des résultats. Dans le cadre de l’Imagerie Médicale, il faut que ces données viennent de patients différents pour prendre en compte la variabilité entre deux individus, sinon les résultats seront biaisés. La difficulté est donc d’avoir une IA performante à la fois sur les données qu’elle aura rencontrées lors de son apprentissage et sur d’autres inconnues car sans cela, elle n’a aucun intérêt médical.

- Utiliser une méthode d'évaluation adaptée

Pour évaluer une solution d’IA, il convient de pouvoir la comparer à une référence qui peut être des experts indépendants comme des radiologues experts dans leurs domaines. Il faut pouvoir comparer sur de nombreux cas avec plusieurs d’entre eux. Si l’IA donne des résultats semblables à ceux des références, le modèle peut être validé.

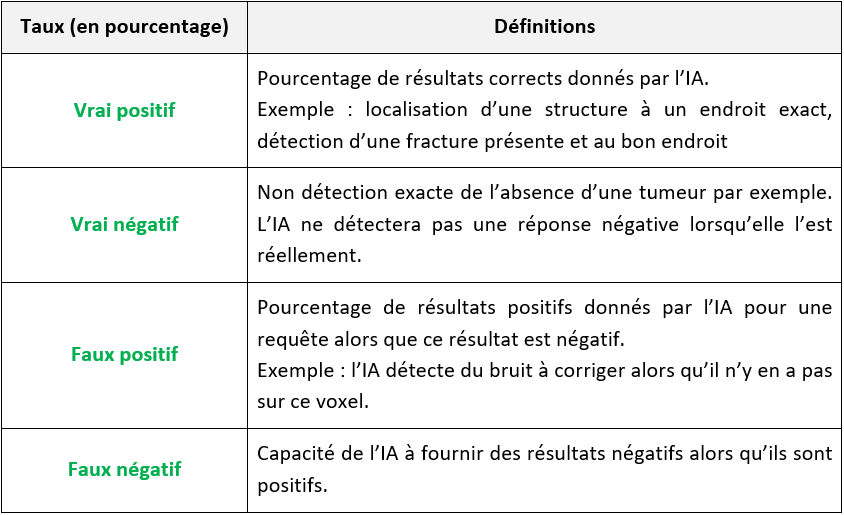

Pour finir, pour évaluer concrètement une IA, il faut connaître les taux de vrais positifs, vrai négatifs, faux positifs et faux négatifs (voir Tableau n°4).

Tableau n°4 : Méthode d’évaluation de l’IA selon les taux de vrai positifs/négatifs et faux positifs/négatifs

Avec une IA qui donne un grand nombre de faux positifs, beaucoup de patients ne seront pas diagnostiqués correctement. Cela sera amplifié si les radiologues n’ont pas le réflexe de vérifier les résultats donnés par l’IA. Évidemment la confiance accordée à une solution dépend de son taux de vrais positifs et négatifs : ces pourcentages doivent être très proches de 100%. Ce sont donc des points de comparaison très intéressants et compréhensibles pour un praticien.

- Aspects réglementaires et aide à la décision d’achat

Omoumi et al. ont publié un article sur des questions pertinentes à poser aux fournisseurs [29].

D’un point de vue réglementaire, il faut également s’assurer du marquage CE des logiciels. Des réflexions sont en cours sur des méthodes de certification des IA. Le principe serait semblable à des contrôles métrologiques par des organismes certifiés. Le but serait d’élaborer des protocoles de test d’IA. Cédric Villani a d'ailleurs montré ce besoin dans son rapport sur l’IA en mars 2018 [49]. Concrètement, il sera possible d’évaluer les IA uniquement sur leur capacité à fournir un bon résultat. Cependant dans le cas de la santé, il serait plus judicieux d'approfondir sans se baser seulement sur le taux d’erreur. En effet, il faut notamment prendre en compte la précision des IA de segmentation ou la perte de signal pour une IA qui modifie la qualité d’une image par exemple.

La robustesse de l’IA est importante et peut être évaluée en la confrontant à un grand nombre de données diverses et inconnues. Si elle est robuste, l’IA continuera de répondre positivement face aux problèmes posés au fur et à mesure du défilement des données.

Pour objectiver sa méthode d’évaluation, poser des questions sur le développement des IA permet de répondre aux points présentés ci-dessus. Certaines IA ne sont entraînées que par des images d’un même constructeur, il est donc judicieux de savoir si cette technologie est applicable avec d’autres machines d’imagerie. Cependant, elles restent souvent optimisées que pour un fournisseur : les IA de fabricants généralistes ne seront disponibles que pour des machines définies. Les IA développées par des start-ups sont souvent entraînées sur des données issues de machines différentes grâce aux partenariats : elles ont donc accès à des qualités d’images différentes et plus de variabilités.

Il est possible de s’appuyer sur des organismes comme le Laboratoire National de métrologie et d’Essais (LNE) qui est un établissement public à caractère industriel et commercial. En plus de travailler sur la création d’une plateforme d’évaluation de l’intelligence artificielle (LEIA) [50] pour 2022, il organise des évaluations de systèmes utilisant l’IA pour de la vidéo et de l’image, notamment avec de la reconnaissance de formes. Des environnements de test avec un afflux important de données peuvent être aussi reproduit. Les logiciels d’IA pourraient ainsi être amenés à nécessiter une certification après évaluation de leurs performances et caractéristiques pour entrer sur le marché.

L’article d'Omoumi et al. « To buy or not to buy - evaluating commercial AI solutions in radiology (the ECLAIR guidelines) » [29] cité plus haut met en évidence dix points à contrôler pour évaluer une IA en radiologie. Cela est divisé en cinq parties comprenant la pertinence de l’IA (réponse aux besoins et champ d’application, avantages et risques), la pertinence et la validation (algorithmes et leurs spécifications) et l’intégration de l’IA (comment l'intégrer dans des activités existantes, ses exigences matérielles et l’interopérabilité avec les autres systèmes d’imagerie comme le PACS). Vient ensuite l'aspect réglementaire où la solution doit être conforme aux réglementations en vigueur sur les DM. Le dernier point est l’aspect financier et il peut être le point le plus important pour certains. L’IA est censée faire gagner du temps mais il faut prendre en compte les coûts d’installation, de formations et de maintenance. Le temps d’analyse est aussi à prendre en compte car il faut que le résultat rendu par l’IA soit le plus court possible, voire imperfectible. Cependant, le point le plus important est certainement la réponse aux besoins bien identifiés. Si un service d’urgences est encombré par l’afflux de patients en attente de prise d’images médicales, il peut être intéressant de choisir une IA qui permet de gagner du temps. A l'inverse, une IA qui améliore la qualité des images est intéressante dans les centres qui font aussi de la recherche et où il faut beaucoup de précision et de détails dans les images.

L’évaluation des solutions doit donc se faire en fonction des besoins de toutes les parties prenantes avec la recherche du meilleur compromis. Il faut néanmoins garder à l’esprit que le patient est le réel bénéficiaire du choix.

Il reste malheureusement une complication avec l’IA : la difficulté d’accéder aux paramètres de décisions et donc de justifier le résultat, d’où la nécessité d’avoir une seconde validation par un médecin. Pour les décisionnaires avertis, l‘article “Acheter ou ne pas acheter – évaluer les solutions commerciales d’IA en radiologie (les lignes directrices d’ECLAIR)” permet d’avoir accès à plus de détails sur le sujet.

- Indice de Jaccard

Aussi appelé Coefficient (ou indice) de Jaccard, il est utilisé pour comparer la similarité entre deux ensembles : ici, il s’agit d’images. Son écriture mathématique est la suivante :

J(A,B) = (A ∩ B) / (A ∪ B)

L’indice de Jaccard permet donc d’extraire le rapport de la taille de l’intersection entre deux ensembles et il est utilisé dans les outils de segmentation pour qualifier chaque segmentation et retenir celles avec l’indice le plus élevé.

Le plus gros inconvénient de cet indice est qu’il demande beaucoup de ressources pour être calculé et peut prendre un temps important pour les gros ensembles comme une image reconstruite en 3D. Ces dernières sont plus difficiles à analyser à cause d’une multitude d’images superposées. Par exemple, une zone qui sera identifiée comme une fracture dans un os sera comparée aux apprentissages du logiciel annotés comme une fracture et l’IA pourra déterminer avec l’indice de Jaccard le taux de la ressemblance à une fracture [51].

- Indice de Sørensen-Dice

Cet indice est un outil mathématique qui mesure la similarité de deux échantillons, il est égal au double du nombre d'éléments communs aux deux ensembles divisés par la somme du nombre d'éléments de chaque ensemble. Il est utilisé en complément de l’indice de Jaccard et son utilisation en est proche

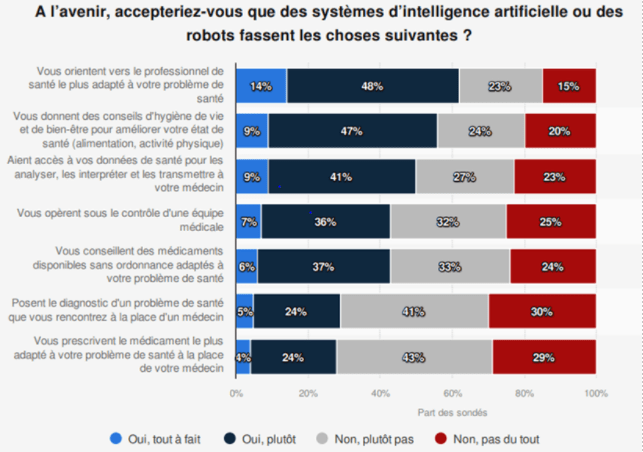

- Nécessité de sélectionner une IA aujourd’hui